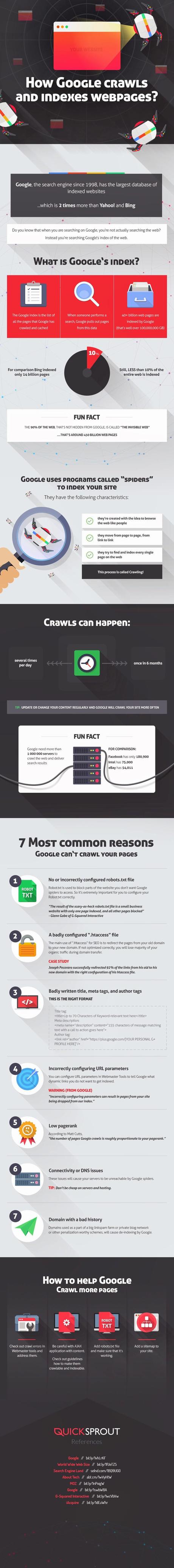

¿Sabías que… Cuando estás realizando una búsqueda en Google, de hecho no estás buscando en la web? En realidad estás buscando en el índice de la web que tiene Google.

Google es el buscador por excelencia desde 1998, y a la fecha tiene la base de datos de sitios web indexados más grande, aproximadamente 2 veces más que la de Yahoo y Bing.

El índice de Google es la lista de todas las páginas que ha rastreado y tiene en caché. Cuando realizas una búsqueda, Google obtiene las páginas e información relacionada de estos datos.

Pero ¿cómo es rastreada la información? y mejor aún ¿cómo puedes indexar más páginas?

La siguiente imagen creada por Quick Sprout da un vistazo a la ciencia detrás de los robots de Google y la indexación de páginas web.

Entre otras cosas nos damos cuenta que:

1. Google ha indexado +40 billones de páginas web, aproximadamente 100,000,000 de gigabytes.

2. A la fecha se ha indexado menos del 10% de toda la web.

3. Google necesita más de 1,000,000 de servidores para rastrear la web y entregar los resultados, para tener una perspectiva, Facebook necesita sólo 180,900 servidores, eBay requiere 54,011 e Intel 75,000.

4. Las razones más comunes por las que no se pueden rastrear tus páginas son: mala configuración del archivo robots.txt, mala configuración del archivo .htaccess, títulos y meta etiquetas mal escritos, parámetros URL incorrectamente configurados, pagerank bajo, problemas con la conectividad o DNS y un mal historial del dominio.

5. Para aumentar el número de páginas indexadas puedes: utilizar las herramientas de webmaster que ofrece Google, añadir el archivo robots.txt y asegurarte que funciona, añadir un mapa de sitio.