No cabe duda de que a nivel técnico, las protagonistas indiscutibles de la inteligencia artificial moderna son las redes neuronales, bajo el cada vez más amplio paraguas del deep learning.

No cabe duda de que a nivel técnico, las protagonistas indiscutibles de la inteligencia artificial moderna son las redes neuronales, bajo el cada vez más amplio paraguas del deep learning.Y en los últimos meses, con el auge imparable (y merecido, diría yo), de la inteligencia artificial generativa, muy especialmente en lo relativo a grandes modelos de lenguaje y modelos fundacionales, parece como si no existiese nada más que redes neuronales. Pudiera parecer, que, 'la cosa' consiste únicamente, en hacer redes neuronales cada vez con más capas, cada vez con más neuronas, cada vez con más parámetros, y de una forma, casi mágica, esas redes son capaces de aprender casi cualquier cosa, y en concreto, el uso del lenguaje.

Y parece como si otras formas de inteligencia artificial, como la más tradicional, como la que se basa en lógica, en representación simbólica del conocimiento o el algoritmos de búsqueda en un espacio de estados ya no tuviesen ningún lugar en la inteligencia artificial actual.

Pero eso no es así del todo... y puede serlo aún menos en el futro.

La emergencia en las primeras redes neuronales: perceptrones y capas densas.

Las primeras redes neuronales, las que probablemente más se acerquen a la emulación del cerebro humano, sí parecían apuntar un poco en esa dirección.

Me refiero al hecho de que, realmente, partían de una neurona artificial relativamente simple, el perceptrón, y a partir de ese elemento, se constituían redes neuronales en que se establecían capas de este tipo de neuronas que se interconectaban luego, 'todas con todas' formando las denominadas capas densas y el conjunto, el denominado perceptrón multicapa.

Aunque no deja de ser una simplificación lo que voy a decir, esos conjuntos de neuronas, ese perceptrón multicapa, era una especie de masa (no gelatinosa sino digital) de neuronas de las cuales, mediante algoritmos relativamente simples, surgían capacidades inteligentes.

Hablo del perceptrón multicapa y de las capas densas como algo del pasado pero no es así: siguen siendo muy utilizadas y, aparte de otras muchas cosas, resultan especialmente adecuadas para hacer una clasificación, usándose, por ejemplo, como capas finales en soluciones de visión artificial.

En cualquier caso, y aunque insisto que es una simplificación, este tipo de capas y redes, sí que parecen responder, al menos hasta cierta medida, a la idea de una 'masa de neuronas' sin ningún tipo de elemento simbólico y sin casi ninguna 'dirección' por parte de los diseñadores.

Y ahora explico a qué me refiero con 'dirección'.

La dirección: transformers y grandes modelos de lenguaje.

Cuando miramos las arquitecturas de redes neuronales más novedosas las que se utilizan en la inteligencia artificial generativa y los grandes modelos de lenguaje, los BERT, GPT, y Transformers, por ejemplo, se percibe mucho más eso que he denominado 'dirección'.

Y lo que quiero decir es que los diseñadores de estas redes introducen muchos artificios, muchos elementos de diseño, que se alejan de la idea de una simple 'masa de neuronas' de la que de una forma, no del todo mágica ni del todo espontánea, pero sí un poco maravillosa, un poco sorprendente, emergen comportamientos inteligentes, y pasamos a otras en que el diseñador sabe muy bien lo que está buscando y por qué establece las arquitecturas que establece y los algoritmos que establece. Hay, pues, una dirección.

Así se ve en mecanismos como la autoatención ('self-attention'), la multicabecera ('multi-head') y, en general, todo el diseño de este tipo de redes donde, aunque existe experimentación y prueba y error, siempre lo hace dentro de un marco en que 'el diseñador' sabe muy bien lo que busca y establece, intencionadamente, los mecanismos para ello.

En el fondo, lo que denominado dirección, vendría a ser diseño, diseño racional y consciente, diseño metódico, diseño con motivaciones y apuntando a unos fines.

Un paréntesis: lógica simbólica y representación del conocimiento.

Y en toda esta 'historia' parece que no tienen ningún lugar las formas de inteligencia artificial más tradicionales, las que se basan en la representación simbólica del conocimiento y en las leyes de la lógica.

En esas formas de inteligencia artificial que ahora percibimos como antiguas, como 'viejunas' y que apenas ocupan espacio en la literatura 'popular' sobre inteligencia artificial, la inteligencia no 'emergía' de una masa de neuronas sino que se establecían unas bases de conocimientos, expresados, por ejemplo, mediante hechos y predicados (como se usaba en LISP), o como unos grafos con nodos que representaban entidades y arcos que representaban relaciones entre ellas (en un modelo que recuerda a los modelos relacionales usados en bases de datos) o en reglas como las que luego usaban los motores de inferencia de los antiguos sistemas expertos o, incluso, como simples espacios de estados.

Y en esas formas de inteligencia artificial, se usaba la lógica, proposicional o booleana, o la búsqueda de muchos tipos sobre ese espacio de estados.

Y hablo en pasado, pero tampoco es cierto. La lógica sigue muy viva y la búsqueda en espacios de estados también.

No sólo eso, es que puede que asistamos a una 'resurrección' de la inteligencia artificial simbólica y de la representación del conocimiento.

Teoría y aspiración: la emergencia neuronal de símbolos

A nivel algo más aspiracional que real, la aspiración surge un poco de, por un lado, el deseo de una inteligencia artificial más general y más parecida a la humana y, por otro, de cómo entendemos que podría funcionar el cerebro humano.

Cuando enfocamos el funcionamiento del cerebro humano desde el punto de vista de la psicología, la antropología o incluso la lingüística. tratamos el funcionamiento del cerebro, especialmente su funcionamiento consciente, a un nivel simbólico. Parece que el cerebro trabaja con símbolos (notablemente signos lingüísticos), e imágenes y representaciones más o menos estructuradas del conocimiento que contienen esos símbolos. Y parece que razona, al menos cuando lo hace de forma consciente, con base en reglas más o menos lógicas.

Sin embargo, si miramos a un nivel más microscópico, en el modo en que lo hace la neurociencia, vemos 'masas de neuronas' interconectadas en patrones complejísimos no del todo conocidos aunque técnicas como el fMRI nos han permitido hacer unos 'mapas del cerebro' aproximados.

El paralelismo con la inteligencia artificial está servido, y no es en absoluto casual: tenemos la vieja inteligencia artificial simbólica, que parece acoplarse a la visión más de alto nivel del cerebro, más próxima a la visión psicológica, y tenemos la visión moderna de la inteligencia artificial, más próxima a la neurociencia, con 'masas de neuronas' interconectadas que dan lugar a comportamientos emergentes inteligentes.

Y si parece que en el cerebro humano ambas visiones coexiste, y si parece además que están relacionadas, que los símbolos y la lógica surgen de un sustrato neuronal, parece razonable la teoría, la aspiración y la investigación en busca de que las redes neuronales artificiales pudieran servir de sustrato de un nivel más simbólico, más lógico, más basado en conocimiento y que esa visión simbólica emergiese de alguna forma del sustrato neuronal.

En este campo hay, como digo, líneas de trabajo e investigación aunque, hasta donde se me alcanza, aún estamos lejos de resultados notables.

Las bases de conocimiento en los grandes modelos de lenguaje

Sin embargo, pudieran existir algunos atisbos de coexistencia entre una inteligencia artificial más simbólica y, sobre todo, más basada en el conocimiento, y el deep learning materializado en los grandes modelos de lenguaje.

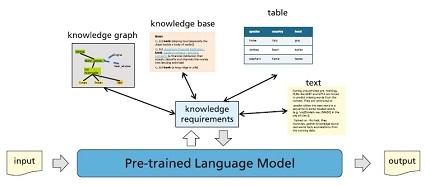

Gran Modelo de Lenguaje alimentado con bases de conocimiento.

Fuente: Gerhard Paas y Sven Giesselbach

Descubro algunos de estos intentos leyendo el libro 'Foundation Models for Natural Language Processing: Pre-trained Language Models Integrating Media' de Gerhard Paas y Sven Giesselbach, un libro complejo pero que, al menos hasta el momento, me está pareciendo muy bueno.

En una sección nos habla de modelos para enriquecer este tipo de modelos con bases de conocimiento factuales ya sea durante el entrenamiento o durante el uso. Describe en bastante detalle (aunque yo lo haré someramente) cuatro formas de dicho enriquecimiento, a saber:

Sección de WordNet.

'Embeddings' de bases de conocimiento: Se parte de bases de conocimiento existentes del tipo de WordNet que adopta la forma de una especie de grafo con entidades y relaciones y se convierte esa información en 'embeddings' similares a los que se utilizan para representar el lenguaje natural. Los autores citan algunos modelos que actúan de esta forma como TransE, KEPLER, KnowBERT o ERNIE-THU.

Fuente: Gerhard Paas y Sven Giesselbach- Codificación textual de tablas: La idea es aportar hechos y conocimiento recogido originalmente en forma de tablas, un formato muy común, por ejemplo, en el mundo empresarial. Para esta situación se utilizan enfoques como el codificar la tabla como lenguaje en un formato especial (tal y como ejemplifican los autores con TURL).

- Codificación textual de bases de conocimiento: Un poco en la línea del primer caso, aunque tratado de forma diferente, en este caso lo que se intenta es convertir las relaciones en una base de conocimiento en texto que es lo que luego de codifica con los correspondientes 'embeddings'. Esto se trata con diferentes variantes de las que los autores nos mencionan y explican brevemente los casos de WKLA, CoLAKE, LUKE, EWISER, PET y TeKGen.

- Adición de hechos: Es una forma de recolectar información adicional sobre conocimiento muy específicos. La idea básica es que un módulo, el 'recolector' recopila la información adicional de nuevas fuentes y la codifica como 'embeddings' mediante un modelo de tipo BERT y otro módulo, que denominan 'lector' recibe el 'embedding' tanto del 'prompt' de entrada como de la información adicional recopilada.

Si observamos todos estos modelos, realmente no estamos generando información simbólica a partir de una información neuronal sino que operamos en sentido contrario: recopilamos información nueva, que procede en general de fuentes de tipo simbólico (es especialmente notorio en ese sentido el primero de los casos descrito), que luego codificamos y convertimos en 'embeddings' para que el gran modelo de lenguaje lo trate de manera casi uniforme con el resto del texto.

Es decir, realmente no estamos cumpliendo, ni de lejos, la aspiración de generar información simbólica emergente a partir de un modelo neuronal pero, de todas formas, si que son casos que mezclan ambos tipos de enfoques y eso, en sí mismo, me parece muy interesante y podría abrir la puerta a nuevos modelos mixtos.

Conclusión

Aunque estamos lejos de un modelo mixto neuronal-simbólico que emule lo que, al parecer, realiza el cerebro humano, hay líneas de investigación y experiencias reales que de alguna forma mezclan ambas visiones incluyendo el caso la interacción con grandes modelos de lenguajes y eso, aparte de los resultados a corto plazo, pudiera abrir interesantísimas y muy prometedoras vías de evolución.