La Regresión de Vectores de Soporte (SVR, del inglés Support Vector Regression) es un algoritmo de regresión basado en los mismos algoritmos que usan las Máquinas de Vectores de Soporte (SVM, del inglés Support Vector Machines) para la creación de modelos de clasificación. Aunque existen algunas diferencias debido a que la salida de una regresión es un valor real y no una etiqueta. Lo que hace que sea muy difícil predecir los valores objetivos. En el caso de una regresión existen infinitas posibilidades, frente al número limitado existentes en los problemas de clasificación.

SVR se puede emplear tanto en regresiones lineales como no lineales.

Regresión de vectores de soporte

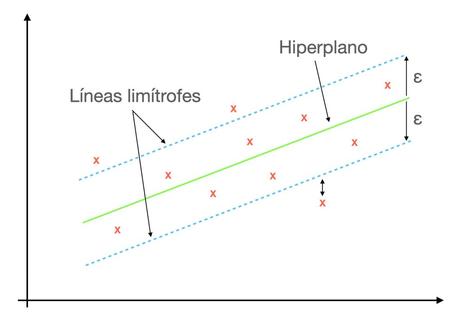

Mientras que en la regresión lineal se busca minimizar una función de error, generalmente el error cuadrático, en todos los puntos del conjunto de entrenamiento, en la SVR se define una zona en torno al hiperplano donde se ignora los errores. Lo que significa que en SVR se busca aproximar el mejor valor dentro de un margen dado por ε, tal como se muestra en la siguiente figura.

Para comprender esta figura es necesario conocer algunos de los conceptos usados como kernel, hiperplano, líneas limítrofes y vector de soporte.

Kernel

En SVR, la regresión se realiza en una dimensión superior. La función de kernel es con la que es posible realizar esta transformación, asignar los puntos de un conjunto de datos de menor dimensión a otro de mayor. Facilitando la búsqueda de un hiperplano en un espacio de mayor dimensión al mismo tiempo que reduce el costo de computación.

Algunos de los tipos de función de kernel utilizado en SVR son Sigmoidal, Polinomico, Gaussiano, etc.

Hiperplano

En los modelos de clasificación SVM los hiperplanos son las líneas empleadas para separar los conjuntos de datos en clases. Aunque, en el caso de SVR, los hiperplanos son las líneas ayudan a predecir el valor objetivo.

Líneas limítrofes

Las líneas limítrofes son las dos líneas que se han dibujado alrededor del hiperplano a una distancia ε. Introduciendo una zona alrededor de la función de kernel, a la que se conoce como tubo, en la que la predicción se considera correcta. Por lo que no se tiene en cuenta los errores de predicción que se comente en esta zona.

Vector de soporte

El vector de soporte es el objeto que se usa para definir el hiperplano.

Conclusión

La Regresión de Vectores de Soporte (SVR, Support Vector Regression) es un algoritmo de regresión que funciona de forma eficiente con conjuntos de datos limitados.

Imagen de Larisa Koshkina en Pixabay