Una reciente revisión sistemática publicada en JMIR pone algo de orden en relación a los proyectos de crowdsourcing en el ámbito de la salud. Un artículo que recopila múltiples iniciativas y las clasifica por temas, fuentes de conocimiento, tipo de crowdsourcing aplicado, etc. Pero, ¿qué es el crowdsourcing? Es algo tan sencillo como compartir un problema con un número muy elevado de personas, permitiendo que cualquiera pueda participar en su resolución (en ocasiones con un pago por su participación) o aportar ideas. También se refiere a la participación en tareas repetitivas para así reducir el tiempo total de ejecución (como por ejemplo en la citizen science).

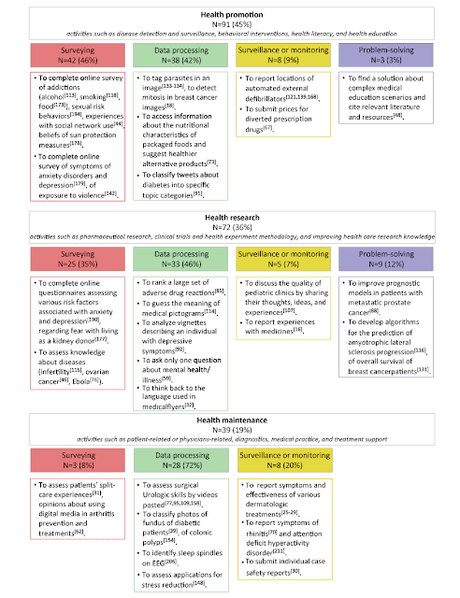

En el terreno de la promoción de la salud, por ejemplo, los casos analizados se refieren al uso de encuestas online para conocer el nivel de adicción a alcohol, tabaco, drogas, etc., a la clasificación de imágenes (mitosis en cáncer de mama o parásitos), localización de desfibriladores, clasificación de tuits, etc. Merece la pena destacar el proyecto para la clasificación de imágenes para el diagnóstico de malaria o AggNet para cáncer de mama. También se incluyen retos abiertos como DREAM Phil Bowen ALS Prediction Prize4Life para el desarrollo de algoritmos para conocer la progresión de la Esclerosis Lateral Amiotrófica (ELA) o plataformas para recogida de datos de salud.La tabla que mostramos a continuación muestra una clasificación de las tareas realizadas con crowdsourcing agrupadas por categorías (en este enlace tenéis también la tabla). El número que aparece junto a cada proyecto lleva a la referencia bibliográfica en el artículo.

Si hablamos de investigación, los ejemplos son más numerosos. Desde cuestionarios para evaluar factores de riesgo, encuestas para evaluar el nivel de conocimiento sobre una patología o factor de riesgo, clasificación de reacciones adversas, analizar material informativo gráfico y en formato texto, recopilar experiencias en el uso de medicamentos o desarrollo de algoritmos de detección de patologías. En este último caso, se recurrió a un reto en abierto con un premio económico para el investigador que desarrollara un algoritmo para predecir la progresión de esclerosos lateral amiotrófica.Uno de los problemas que se plantea en los proyectos asociados con el crowdsourcing es el posible sesgo asociado a la selección de participantes y al pago que se les ofrece. El motivo principal tiene que ver con Amazon, y es su plataforma Amazon Mechanical Turk. Esta plataforma online pone en contacto a miles de "turkers" que se ofrecen para trabajos masivos online, desde rellenar encuestas, hasta revisar webs, o documentos, etc. Tal y como cuentan en este artículo, el pago es muy bajo a los encuestados y además se trata de personas que "viven" de lo que cobran como turkers. Pero el éxito de la plataforma y su uso en el ámbito de la investigación científica es cada vez mayor.

Una de las grandes dudas que hay detrás de todos los estudios y evaluaciones de crowdsourcing es la validez de sus resultados. En la revisión que estamos comentando, 133 estudios del total de 202 evaluados utilizó una plataforma como Amazon Turk o Crowdflower, con los riesgos y sesgos asociados a estas plataformas. Además, el hecho de ser usuarios anónimos y que obtienen una compensación económica por su participación, quizás pueda influir en la calidad de los datos obtenidos.

Un ejemplo paradigmático es la evaluación que realizó un grupo colaborativo de urología para analizar el desempeño de urólogos realizando una prostactectomía radical asistida por robot. Para ello, se dispuso de 12 intervenciones grabadas en vídeo que fueron posteriormente editadas en fragmentos más breves para facilitar la evaluación. Para ello, se utilizaron escalas como Global Evaluative Assessment of Robotic Skills (GEARS). Los expertos del grupo colaborativo evaluaron 318 vídeos en 15 días, mientras que los colaboradores vía crowdsourcing revisaron 2531 vídeos en 21 horas. Pero no solo eso, ya que el nivel de coincidencia en la evaluación fue muy elevado. Y por cierto, se utilizó como plataforma de crowdsourcing la ya citada Amazon Mechanical Turk, por lo que se trataba de colaboradores remunerados sin experiencia ni conocimientos quirúrgicos (salvo la formación inicial para conseguir un mínimo de competencias para la evaluación).

Un tema de gran actualidad, pero con el dilema existente entre la potencia (muchas mentes pensando en lo mismo) y la calidad de la información (sesgo de desconocimiento de la fuente). Además, hay que añadir el uso (o abuso) de plataformas de crowdsourcing como Amazon Turk. Sin embargo, no se puede negar el papel que tienen iniciativas como los premios (hackathon) y la recogida masiva de datos gracias al uso de la tecnología.