El riesgo de la interpretación antropomórfica de la Inteligencia Artificial consiste en interpretar que es, cómo funciona y qué podemos esperar de la Inteligencia Artificial, atribuyéndole, de forma errónea, unas características humanas de las que carece.

Ese riesgo, de forma latente, lo había detectado ya hace mucho tiempo, pero habitualmente lo había calificado con el término bastante menos preciso de 'fantasía' (a veces acompañado del término 'ignorancia'). Sin embargo ha sido una agradable sorpresa encontrarme esa idea de la interpretación antropomórfica en palabras de un gran experto del Machine Learning, como es François Chollet, científico de Google, creador de la librería Keras y autor del libro 'Deep Learning con Python' al final del cual es donde expresa esta idea.

En concreto, lo que menciona Chollet es el riesgo de antropomorfizar los modelos de machine learning. En la traducción al castellano de su libro nos dice:

Un rasgo fundamental de los humanos es nuestra tendencia a proyectar intenciones, creencias y conocimientos en las cosas que nos rodean.

Y llevado ya al caso del machine learning nos pone algún ejemplo muy clarificador de lo que quiere decir. Así, por ejemplo, menciona el reconocimiento de imágenes. En efecto, uno de los grandes éxitos del deep learning en los últimos años es la capacidad para clasificar imágenes. Lo que hace el deep learning es, a través de un largo proceso de aprendizaje basado en ejemplos, ajustar una larga serie de parámetros (digamos, miles de parámetros) de un modelo de red neuronal, hasta conseguir que, con una alta probabilidad, ante una nueva imagen el algoritmo devuelva la clasificación adecuada.

La interpretación antropomórfica de este algoritmo es creer que el algoritmo entiende lo que está viendo, que si lo que ve es un gato y le asigna como etiqueta de salida 'gato' es que sabe que es un gato. Y no. El algoritmo no entiende absolutamente nada, ni sabe absolutamente nada...solo ha conseguido ajustar muy bien sus parámetros de forma que, con una alta probabilidad, ante la imagen de un gato diferente sabrá etiquetarlo como 'gato' y no como 'perro'.

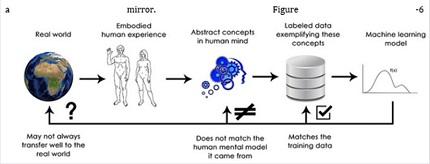

La forma en que funciona el entrenamiento en machine learning de manera general es como se muestra en la figura del propio autor.

Existen una cierta realidad en el mundo real, valga la redundancia, digamos la fauna y los animales que en ella existen. Esa realidad ha pasado por la experiencia humana que realiza una cierta abstracción, en este caso la clasificación de las criaturas vivas en una serie de especies.Y ahora alimentamos (entrenamos al modelo) con ejemplos en que el resultado que consideramos es la asignación de la etiqueta adecuada de entre esas abstracciones realizadas por los humanos. Y el modelo aprende a clasificar las realidades del mundo conforme a esas categorías abstractas que le proporcionan los humanos. Pero no aprende los conceptos abstractos que hay detrás, lo que hace es una simple correspondencia de entradas a etiquetas basada en los datos de entrenamiento, una correspondencia que luego puede representar bien o no con el mundo real..

El hecho de atribuirle al algoritmo una comprensión que no tiene, de creer que realmente ha entendido el significado de las abstracciones, hace que nos sorprenda y hasta parezca risible alguna confusión que puede cometer el algoritmo ante imágenes que para una persona, que sí entiende perfectamente el modelo abstracto que hay detrás, no ofrecen ninguna duda. No nos damos cuenta de que el algoritmo, no sólo no entiende lo que ve, es que además carece de toda la experiencia sensomotora, y todo el contexto que acompaña a los humanos. De hecho, el autor nos explica lo relativamente fácil que es engañar a uno de estos algoritmos si esa es nuestra intención... y forzarle a cometer errores que para un humano serían incomprensibles.

Hasta ahí la explicación de Chollet, pero a mi me gustaría incidir un poco más en el hecho de la desviación antropomórfica que supone atribuirle intención a un algoritmo como si, por ejemplo, ante un sesgo de género o raza debido a los datos de entrenamiento atribuyésemos algún tipo de intencionalidad, intencionalidad perversa además, al algoritmo. Como si el algoritmo realmente decidiese de forma consciente algo.

El riesgo de la interpretación antropomórfica podría no se grave si sólo condujese a fantasías en conversaciones comunes o en entretenidas películas de ciencia ficción.

Pero existe un movimiento cada vez más importante encaminado a analizar con perspectiva ética y legal la inteligencia artificial. Un movimiento que me parece sano y muy necesario...pero siempre que se haga desde el rigor y el conocimiento, huyendo de fantasías y malinformadas interpretaciones antropomórficas.

Si vamos a legislar, más vale que sepamos sobre qué estamos legislando realmente.