Todo empezó cuando Alan Turing se preguntó en 1950 si las máquinas podían pensar. Las novelas de Isaac Asimov —creador de las famosas tres leyes de la robótica—, los mitos de la Grecia antigua y otras anécdotas de siglos pasados evidencian que esa misma pregunta lleva rondando la cabeza de científicos y del público general mucho más tiempo. Seis años más tarde del interrogante de Turing, en una escuela de verano de la Universidad de Dartmouth, en Estados Unidos, Marvin Minsky y sus colegas utilizaron por primera vez el término “inteligencia artificial” (IA). Este concepto tecnológico no se le es ajeno a ningún país desarrollado hoy día, ni su aplicación a las empresas más punteras.

La inteligencia artificial ha demostrado ser útil a la hora de predecir desastres naturales, hacer recomendaciones de productos en tiendas digitales, adelantar trabajo a los abogados, e incluso mejorar el proceso de diagnosis de enfermedades graves. Pero más allá de este brillante futuro, los investigadores ya han citado algunos problemas que manifiesta la inteligencia artificial y, en particular, sus algoritmos, las reglas que rigen a la máquina: desde algoritmos racistas o machistas, hasta la posibilidad de que las máquinas se descontrolen y supongan una amenaza existencial para el ser humano.

La utopía de tener un agente inteligente no orgánico obedeciendo órdenes también ha captado la atención de los Ministerios de Defensa en todo el mundo. En 2017, China hacía pública su estrategia para posicionarse a la cabeza en investigación de IA. Un año más tarde, Estados Unidos asignaba una partida de 2.000 millones de dólares al avance de esta tecnología. Países como Rusia, Japón, Reino Unido o España también se han sumado haciendo grandes contribuciones a este pulso global, lo cual ha creado una sensación generalizada de una nueva carrera armamentística que vuelve a pasar por universidades, empresas privadas y Gobiernos.

Cerebros o algoritmos

John McCarthy, uno de los pioneros en el mundo de la inteligencia artificial, la definió en 1956 como “la ciencia de crear máquinas inteligentes”. Aunque la definición de inteligencia es controvertida, los primeros científicos dedicados a la IA propusieron el lenguaje como una forma de canalizarla y manifestarla. Uno de ellos, Alan Turing, famoso también por decodificar la máquina Enigma que permitió a los aliados descifrar las comunicaciones nazis y ganar la guerra, desarrolló un famoso test mediante el cual se consideraría a una máquina “inteligente” si era capaz de conversar con un humano sin que este reconociera que su interlocutor era un robot.

La idea del humanoide que piensa y habla es probablemente la imagen más extendida de la inteligencia artificial, pero en realidad es sólo uno de los mitos que la rodean: una IA no necesita de un cuerpo propiamente dicho, sino que le basta con conexión a la red eléctrica; a veces ni siquiera es necesario internet. Tampoco son máquinas que acabarán por sustituir a los humanos en el proceso de toma de decisiones, como sucede con el yogur superinteligente de la famosa serie de Netflix Love, Death + Robots, ni terminarán con la humanidad, como Skynet en Terminator.

Aunque el desarrollo ético de la inteligencia artificial es uno de los puntos que más preocupan a los investigadores, se debe a una cuestión de alineamiento, es decir, que el camino que un agente artificial elija para resolver un problema sea el considerado “bueno” por un ser humano. Por ejemplo, ante el objetivo de hacer sonreír a una persona, la IA podría optar por estirarle los pómulos para cumplir el objetivo a toda costa, lo que supondría un claro caso de desalineamiento. El desarrollo de la inteligencia artificial se puede sintetizar en tres preguntas clave: cómo podemos enseñar a las máquinas a ser “inteligentes”, qué les enseñamos y por qué.

Tanto humanos como máquinas necesitamos altas dosis de información para entender lo que pasa a nuestro alrededor. Privadas de sentidos, las máquinas son capaces de representar el mundo exterior a través de paquetes de datos. El contenido de esos datos es vital para la construcción de la “mente” artificial; también las propias características cognitivas y morales del matemático que desarrolla el algoritmo, pues de ellas depende la conciencia de la IA. En otras palabras, el matemático juega el rol de padre o madre, los datos educan a la máquina. Eso presenta un problema: los sesgos de los desarrolladores pueden acabar trasladándose a la IA, que podría asumir inclinaciones machistas o racistas. Un ejemplo es COMPAS, un algoritmo utilizando en el sistema judicial estadounidense para evaluar, entre otras variables, el riesgo de reincidencia de los delincuentes; el algoritmo identifica más fácilmente a afroamericanos como posibles reincidentes que a estadounidenses blancos.

Los algoritmos utilizados permiten que la IA identifique, clasifique, categorice y generalice mediante los métodos de machine learning (‘aprendizaje automático’) y de deep learning (‘aprendizaje profundo’), más sofisticado. El primero trata de alimentar a la máquina con altas dosis de datos predefinidos y categorizados por el humano para que la máquina los reconozca en el futuro y reequilibre su modelo de análisis según la experiencia para reducir el margen de error. El segundo, más preciso, hace pasar la información por múltiples “capas”, que se asemejan a una red neuronal, y permite a la IA fijarse en más detalles y crear sus propios modelos de referencia. A día de hoy, una IA puede ganar a un experimentado ajedrecista, como sucedió con Gari Kaspárov en 1997, e incluso batir a un campeón de Go, un antiguo juego de estrategia chino conocido por su extrema complejidad.

Según la capacidad de identificación y correlación de datos que tenga, la inteligencia artificial se divide en varias categorías. La IA “estrecha” o “débil” se encarga de una tarea automáticamente, haciendo clasificaciones de acuerdo con unos parámetros predeterminados que va puliendo según la cantidad de datos disponible. Se trata de tareas rutinarias y técnicas como recomendar vídeos en YouTube sobre la base de los gustos del usuario, o clasificar correos electrónicos en deseados o no deseados. El segundo tipo de IA, todavía más teórico que real, es la llamada IA “general” o “fuerte”. Supone capacidad de abstracción, reflexión, afán creativo e improvisación, y es el paso anterior a la creación de una superinteligencia, según el académico de la Universidad de Cambridge Nick Bostrom. La IA fuerte tendría, además, la capacidad de crear a otras IA, por lo sería, como dijo antaño otro científico, el último invento de la humanidad.

Para ampliar: “¿Sueñan los androides con quitarnos el trabajo?”, Fernando Arancón en El Orden Mundial, 2018

¿Una nueva carrera armamentística?

Las posibilidades de minimizar los riesgos humanos y maximizar la eficacia en un escenario de conflicto hace que los primeros interesados en apostar por la inteligencia artificial sean los ejércitos. De hecho, el líder ruso Vladimir Putin incluso ha sentenciado que “quien lidere la carrera por la inteligencia artificial gobernará el mundo”. Las aplicaciones de la inteligencia artificial en el mundo de la seguridad y la defensa son múltiples: pueden acelerar la identificación de sospechosos por su capacidad para encontrar patrones y seleccionar imágenes, formar personal militar en un entorno concreto a través de simulación de escenarios, reforzar la resiliencia de los sistemas informáticos, reducir el número de soldados humanos en el campo de batalla o ampliar la precisión del armamento militar.

Las armas autónomas son una de las caras más visibles de esta nueva generación. Definidas por el Departamento de Defensa de EE. UU. como sistemas que pueden “seleccionar e interactuar con un objetivo sin intervención de un operador humano”, son especialmente útiles en misiones de reconocimiento o patrullaje en el exterior. Su capacidad de acercarse al objetivo también las hace muy apropiadas para misiones peligrosas o de larga duración, con lo que se reducen así todos los riesgos derivados de las propias necesidades de la especie humana, como la fatiga, el estrés, el miedo o los dilemas morales, así como el riesgo de perder información sensible si una persona es capturada. Además, la IA aprendería del entorno y procesaría información sobre este, ampliando el grado de éxito de las misiones. Optimizar el procesamiento de datos también mejoraría el funcionamiento de las agencias de inteligencia, algo especialmente útil tanto en momentos de paz como en momentos de guerra.

La inteligencia artificial ofrece muchas oportunidades en el ámbito militar, y daría una ventaja estratégica a quien la controlara. Así, las guerras del futuro podrían estar protagonizadas por enjambres de “robots asesinos”, como son popularmente conocidos, actuando de manera coordinada contra ejércitos enemigos. Por eso, el desarrollo de la inteligencia artificial abre la posibilidad de una nueva carrera armamentística.

Para ampliar: “Amazon contra Microsoft: las tecnológicas entran en la industria de defensa”, Diego Mourelle en El Orden Mundial, 2019

A finales de la presidencia de Barack Obama, en octubre de 2016, la Casa Blanca publicó un informe en el que subrayaba los riesgos y las oportunidades de la inteligencia artificial para la economía y la seguridad estadounidenses. Tras la elección de Donald Trump, la apuesta de la Casa Blanca por la inteligencia artificial pareció reducirse hasta que en febrero de 2019 se anunciaron una serie de medidas para mantener el liderazgo en IA de Estados Unidos. Pocos meses antes, el Pentágono inauguraba el programa AI Next con una inversión cercana a los 2.000 millones de dólares. Todo ello en el contexto de la guerra comercial con China, en la que las rivalidades tecnológicas juegan un papel fundamental.

Para muchos analistas, China tiene todas las de ganar la carrera por el dominio de la inteligencia artificial. Es un país con un territorio más grande y más diverso en climas y paisajes que sus competidores. Además, poblacionalmente es mucho mayor y la cultura asiática tiene una concepción de privacidad diferente a la occidental. Mayor población significa más datos con los que alimentar a los algoritmos, mientras que la diversidad geográfica supone variedad de escenarios en los que entrenarlos. Ejemplo de ello es el Plan de Desarrollo de la Inteligencia Artificial de 2017, que tiene como objetivo convertir a China en líder en IA para el 2030.

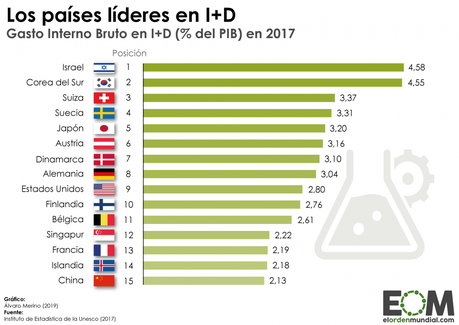

Los esfuerzos chinos en esta materia son una continuación natural del plan “Made in China 2025”, una estrategia que tiene como objetivo hacer de China un país puntero en tecnología. Por número de patentes y de artículos más citados, China ya supera a Estados Unidos, aunque le faltan investigadores que sigan impulsando su industria. Otros países como Japón o Israel también están haciendo contribuciones importantes en el campo de la inteligencia artificial, pero su inversión es considerablemente menor y no tienen la capacidad de liderar el campo de la IA a nivel mundial.

Para ampliar: “Who Will Win the AI Race?”, Yuval Noah Harari en Foreign Policy, 2019

Adónde vamos

El desarrollo de tecnología puntera suele estar reservado a países lo suficientemente ricos como para poder permitirse grandes inversiones en I+D, que además son los primeros en beneficiarse económica y militarmente. Es lo que podría derivar en el “colonialismo de datos”, como lo ha llamado el intelectual israelí Yuval Noah Harari: una nueva y desigual manera de interactuar entre Estados en la que las empresas recolectarían datos de países con legislaciones de privacidad menos desarrolladas para procesarlos en los países donde se dispone de IA y aplicar ahí los beneficios.

La inteligencia artificial es un campo que ya está dando grandes resultados. No obstante, rodeada de mitos y de ficción, las primeras aplicaciones visibles de la inteligencia artificial podrían generar rechazo en el público y suponer un contragolpe a su desarrollo, sobre todo en el ámbito militar. Iniciativas como Campaign to Stop Killer Robots (‘Campaña para detener a los robots asesinos’), suscrita por organizaciones como Human Rights Watch, tratan de regular la actuación de las armas autónomas y frenar su desarrollo.

Es innegable que la IA penetrará en nuestra vida diaria, ya lo está haciendo. Por ello cabe preguntarse cuál es el objetivo de su investigación, sopesar las consecuencias y vigilar que el procedimiento siga una línea lógica y ética. Probablemente este sea uno de los puntos que debería preocuparnos: cómo algoritmos imperfectos pueden encontrar su sitio en lugares tan importantes como los ejércitos, los despachos de abogados o las comisarías de policía. Supervisar que sea siempre un humano, y no una IA —cuyas decisiones a veces no sabemos justificar— el que tome las decisiones más importantes es una de las tareas pendientes de aquellos que tratan de regular el desarrollo y el uso de la inteligencia artificial.

Para ampliar: “La roboética en tiempos de poshumanidad”, Andrea G. Rodríguez en El Orden Mundial, 2018

La inteligencia artificial, ¿la ventaja geopolítica definitiva? fue publicado en El Orden Mundial - EOM.