Mi idea de hacer una entrada sobre el temas de las (vilipendiadas) encuestas y los resultados de la elección del domingo 17 se facilitó enormemente por el hecho que Kenneth Bunker en TresQuintos.com, al evaluar los pronósticos de la elección (incluyendo el suyo) mostró algunos cuadros resumen de lo que sucedió con las encuestas.

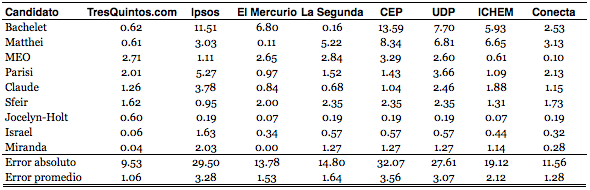

El cuadro más relevante para analizar la situación de las encuestas es el tercero de la entrada que comentamos que es el siguiente:

El pronóstico de TresQuintos se basa en un modelo de agregación de los resultados de encuestas (usando un modelo bastante más complejo que un simple promedio en cualquier caso, se usa Bayes, simulaciones de MonteCarlo, se ajuste por varios parámetros etc.). Ahora, dado que usa las encuestas como insumo y no es un pronóstico independiente, no sirve para responder la pregunta de si las encuestas lo hicieron bien, que es lo que nos interesa aquí.

El dato ‘predicho’ por cada encuesta corresponde al porcentaje de preferencia por candidato sobre el total de preferencias declaradas en esa encuesta, que es equivalente a cómo funciona el sistema electoral: En el que sólo se cuentan los votos válidamente emitidos para calcular porcentajes (En ese sentido, el valor CEP de Bachelet es de un 60% por ejemplo). Se puede discutir si esto es o no adecuado, pero dado que replica cómo funciona el sistema no parece ser completamente inadecuado.

Más allá de los preliminares, podemos observar que la situación no es tan compleja como pudiera parecer a primera vista. Conecta se mantiene dentro o cerca del margen de error en todos los casos, Opina y La Segunda tienen errores relevantes en un candidato (Bachelet y Matthei respectivamente). Por otro lado, las encuestadoras grandes sí tienen diferencias importantes -CEP e Ipsos. Ahora bien, dado que hay una diferencia entre la fecha de las encuestas y la fecha de la elección, una diferencia de resultados es esperable porque entre medio bien puede cambiar la realidad (i.e que a la fecha de la encuesta la diferencia con el valor real era menor, y que los altos valores de diferencia sean además producto de una diferencia en la realidad). En otras palabras, los resultados no quieren decir necesariamente que CEP estuviera equivocado en la encuesta de Octubre.

Lo que sí quieren decir es que (a) efectivamente resulta posible tener buenos estimadores de una elección bajo voto voluntario y que (b) queda todavía harto trabajo que hacer para disminuir los errores. Pero esto requiere hacer investigación metodológica, en por ejemplo ¿que tipo de preguntas son adecuadas para filtrar votantes? Dado que las distintas encuestas no hicieron las mismas preguntas para ello bien serviría para evaluar cual funciona mejor -aunque, claro está, requeriría que los cuestionarios fueran públicos, lo que no siempre ocurre, pero parece ser -si queremos mejorar las estimaciones- necesario.

Finalmente, un excurso: Un modelo de agregación bien hecho debe dar menores errores que cada encuesta en particular. Recordemos que cada encuesta extrae una muestra de todas las muestras posibles, y que si no hay sesgo y son aleatorias el promedio de la distribución de todas las muestras es equivalente al promedio del universo. Ahora bien, agregar es análogo a extraer más muestras de esa distribución y por lo tanto a acercarse al promedio del universo. Lo anterior, por cierto, que simplifica mucho del trabajo de un modelo agregado (en que hay que corregir por los sesgos, tomar en cuenta varios parámetros, y por cierto no es exacto decir que son varias muestras del mismo universo); pero nos explica la utilidad y relevancia de ese trabajo: Si se construye un buen modelo, entonces tenemos una alta probabilidad de tener un mejor pronóstico que el que entrega cada encuesta por separado, que es lo que interesa finalmente.