Dos matemáticos y un físico, DaríoBenedetto, Emanuele Caglioti y Vittorio Loreto de la Universidad deLa Sapienza en Roma, decidieron poner a prueba el algoritmo Lempel-Ziv como método de identificación de creadores literarios. Su objetivo era identificar a los autores de obras literarias. Noventa textos escritos por 11 autores italianos (entre ellos Dante Alighieri y Pirandello) sirvieron como material de base. Se elegía el texto de un autor determinado y se le unían dos pequeños textos de igual tamaño: uno del mismo autor y otro de un autor diferente. Se introducían estos archivos en un programa de compresión, como el popular WinZip, y los científicos comparaban cuánto espacio de almacenamiento necesitaba cada uno. Conjeturaron que la entropía relativa del texto combinado les daría una idea sobre la autoría del texto anónimo. Si ambos eran obra del mismo autor, el algoritmo necesitaría menos espacio de almacenamiento que si el texto adjunto estaba escrito por otro diferente. En el segundo caso, la entropía relativa sería mayor, dado que el algoritmo tendría que considerar los distintos estilos y palabras usadas por ambos autores. En consecuencia, necesitaría más espacio para almacenar el archivo. Cuanto más pequeño fuera el archivo comprimido de los dos textos combinados, más probable era que el texto original y el adjunto pertenecieran al mismo autor. Los resultados del experimento fueron francamente increíbles. Cerca del 95% de las veces los programas de compresión permitieron identificar correctamente al autor.

Seguramente embargados por la emoción del éxito de su nuevo enfoque, los tres científicos no se dieron cuenta, o al menos olvidaron mencionar en su bibliografía, que su método no era tan original como creían. De hecho, no fueron los primeros en pensar que los métodos matemáticos se podrían usar para atribuir textos literarios a sus autores. George Zipf, profesor de Lingüística en Harvard, ya había abordado temas como la frecuencia de palabras en 1932. Y el escocés George Yule había demostrado en 1944, en un artículo titulado Estudio estadístico del vocabulario literario, cómo había podido atribuir el manuscrito De imítatione Christi al conocido místico Tomás de Kempis, que vivió en los Países Bajos en el siglo XV. Y por supuesto, hay que mencionar los papeles federalistas del siglo XVIII, cuya autoría por parte de Alexander Hamilton, Iames Madison y Iohn Iay fue determinada por los estadísticos americanos R. Prederick Mosteller y David L. Wallace.

Dado que todo les había ido tan bien, Benedetto, Caglioti y Loreto decidieron llevar a cabo otro experimento. Analizaron los grados de afinidad entre lenguajes diferentes. Dos lenguas que pertenezcan a la misma familia lingüística deberían tener una entropía(1) relativa baja. Por tanto, podría comprimirse de forma más eficiente una combinación de dos textos escritos en lenguas que estén emparentadas que dos que pertenezcan a familias diferentes. Los científicos analizaron 52 lenguas europeas. De nuevo, tuvieron éxito. Usando el programa de compresión, pudieron clasificar cada lengua en su grupo lingüístico correspondiente. El italiano y el francés, por ejemplo, tienen una entropía relativa baja y por tanto pertenecen a la misma familia. El sueco y el croata, por otro lado, tienen una entropía relativa alta y por tanto han de provenir de grupos lingüísticos diferentes. WinZip consiguió incluso identificar el maltés, el vasco y el húngaro como lenguajes aislados que no pertenecían a ninguno de los grupos lingüísticos conocidos.

El estudio completo se puede consultar en. Dario Benedetto, Emanuele Caglioti, Vittorio Loreto, "Language Trees and Zipping", Phys. Rev. Lett., 88, 048702 (2002)

(1)

Para entender la compresión de datos, es necesario familiarizarse con el concepto de entropía. En física, la entropía es una medida del desorden de un sistema, por ejemplo un gas. En telecomunicaciones, la entropía es una medida del contenido en información de un mensaje. Un mensaje que consista, por ejemplo, en 1.000 repeticiones del número 0 tiene muy poco contenido en información y una entropía muy baja. Se puede comprimir a la pequeña formula 1000x0 Por otro lado, una secuencia totalmente aleatoria de unos y ceros tiene una entropía muy alta. No se puede comprimir en absoluto, y la única forma de almacenar dicha secuencia es repitiendo todos sus caracteres. La entropía relativa indica cuánto espacio de almacenamiento se ocupa si una secuencia de caracteres se comprime, con un método que se había optimizado para una secuencia diferente. El código morse, concebido para el inglés, puede ser un ejemplo. La letra que aparece mas frecuentemente en inglés, la e, obtuvo el código mas corto: un punto. Las letras que aparecen menos obtienen códigos mas largos, por ejemplo <<—.-» para la -q-. Para otras lenguas, el código morse no es idóneo, porque las longitudes de los códigos no corresponden con la frecuencia de las letras. La entropía relativa mide entonces cuántos puntos y guiones adicionales se necesitan para transmitir un texto, digamos en italiano, con un código que esta pensado para el inglés.

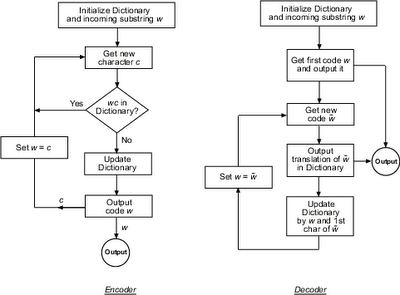

La mayoría de las rutinas de compresión de datos estén basadas en algoritmos desarrollados a finales de los años setenta por dos científicos israelíes del Technion en Haifa. El método que desarrollaron Abraham Lempel, informático, y de Jacob Ziv, ingeniero electrónico, se basa en el hecho de que en un archivo aparecen secuencias idénticas de bits y bytes. La primera vez que una secuencia aparece en el texto, se introduce en una especie de diccionario. Cuando vuelve a aparecer la misma secuencia, un marcador señala el lugar adecuado del diccionario. Dado que el marcador ocupa menos espacio que la secuencia, el texto se comprime. Pero aún hay mas. La distribución de la tabla que lista todas las secuencias no sigue las reglas de clasificación de un diccionario normal, si no que se adapta al archivo en concreto que queremos comprimir. El algoritmo <<aprende>> a distinguir qué secuencias aparecen mas a menudo y adapta la compresión a ellas. Cuando el tamaño del archivo aumenta, el espacio necesario para almacenarlo crece hacia la entropía del texto.

Fuente: La vida secreta de los números. GEORGE G. SZPIRO, ALMUZARA, 2009 ISBN 9788492573288

Este artículo es mi primera colaboración con la Edición 2.8 del Carnaval de Matemáticas, que en esta ocasión organiza Ciencia Conjunta.