La inteligencia artificial, y dentro de ella el deep learning y la inteligencia artificial generativa, se han visto sacudidas en los últimos meses, al menos a nivel mediático (a nivel técnico ya llevaba sucediendo desde hace más tiempo) por los impresionantes resultados conseguidos con base en la arquitectura 'transformer', una arquitectura compleja de red neuronal que, sin embargo, tampoco es perfecta y aún tiene pendientes algunos retos.

La inteligencia artificial, y dentro de ella el deep learning y la inteligencia artificial generativa, se han visto sacudidas en los últimos meses, al menos a nivel mediático (a nivel técnico ya llevaba sucediendo desde hace más tiempo) por los impresionantes resultados conseguidos con base en la arquitectura 'transformer', una arquitectura compleja de red neuronal que, sin embargo, tampoco es perfecta y aún tiene pendientes algunos retos.En este post pasamos revista brevemente a algunos de ellos.

Una arquitectura de éxito

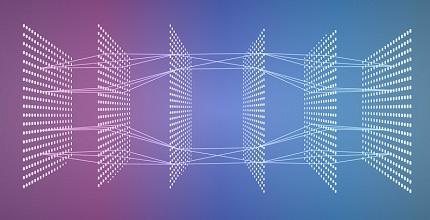

La arquitectura transformer vio la luz pública con el famoso artículo 'Attention is all you need' escrito por varios investigadores de Google. En él se propone un mecanismo, la atención, que permite superar los resultados obtenidos con, por ejemplo, las redes neuronales recurrentes, dominadoras del panorama de las redes neuronales para procesamiento de lenguaje natural en ese momento.

Las redes neuronales recurrentes son unas redes 'con memoria' obtenida a partir de una realimentación de la salida hacia la entrada lo que, de alguna forma, permite una especie de serie temporal en que los resultados en un momento dependen del resultado en el punto anterior.

El mecanismo de atención, extiende de alguna forma ese esquema, prestando 'atención' valga la redundancia, no sólo al estado anterior sino a todos los anteriores.

El caso es este mecanismo de atención, ha servido de base para la arquitectura transformer donde se le ha dado una nueva vuelta de tuerca introduciendo la 'auto-atención' que ya no me pararé a describir aunque seguramente valga la pena profundizar más en esta arquitectura, cosa que a lo mejor hago en algún otro post (aunque tendría que buscar la forma de hacerlo de manera sencilla).

La arquitectura transformer está por detrás de muchos de los impresionantes recientes resultados obtenidos en materia de lenguaje natural y de inteligencia artificial generativa, incluyendo los modelos GPT y, claro, el omnipresente ChatGPT.

Los retos para los transformer

Sin embargo, nada en este mundo es perfecto y la arquitectura transformer, en que todavía hay mucho trabajo en investigación y evolución, no está exenta de limitaciones y problemáticas a afrontar.

En el excelente libro 'Natural Language Processing with Transformers', sus autores, Lewis Tunstall, Leandro von Werra y Thomas Wolf, todos ellos pertenecientes a Hugging Face, dedican una pequeña sección, a identificar brevemente algunos de los retos a los que se enfrenta esta arquitectura. Estos son los que nos comentan:

- Idiomas: Como en tantos otros aspectos del procesamiento de lenguaje natural, la investigación y el entrenamiento de modelos está hecho fundamentalmente en Inglés. En este caso, también hay buena disponibilidad de modelos en otros idiomas. Sin embargo, si pensamos en idiomas de no muy amplia difusión puede ser difícil encontrar modelos pre-entrenados.

- Disponibilidad de datos: Los modelos de transformer utilizan el 'transfer learning' (uso de un entrenamiento previo en otras redes o modelos) de forma que se reduce mucho la necesidad de datos etiquetados para el entrenamiento final. Sin embargo, en algunos casos se necesitan esos datos etiquetados de los que no siempre es fácil disponer.

- Trabajo con documentos largos: Los transformer utilizan el denominado mecanismo de 'auto-atención' en que una capa tiene información de todas las capas ocultas anteriores. Este es un mecanismo potente pero también computacionalmente costoso. Por ello, funciona razonablemente bien para textos del orden de un un párrafo o similar, pero se convierte en muy costoso para documentos largos.

- Opacidad: que enlaza con el conocido problema de la explicabilidad (falta de explicabilidad en realidad) de los modelos de deep learning. En efecto, también la arquitectura transformer, que no deja de ser una forma de deep learning, está afectada por esa falta de esa explicabilidad, por la dificultad para entender por qué el algoritmo hace lo que hace.

- Sesgo En general, los modelos transformer existentes se han pre-entrenado con datos procedentes de Internet (como pudiera ser la wikipedia). Por tanto, los modelos heredan de alguna forma todos los sesgos que pudieran estar presentes en esas fuentes y no siempre evitar aspectos como el sexismo, racismo etc son fáciles de eliminar.

Conclusiones

En el fondo, no se trata de problemáticas demasiado sorprendentes, ni siquiera muy específicas salvo, tal vez, la que afecta a los documentos largos. Se trata de problemáticas a los que se enfrenta la inteligencia artificial en general y el procesamiento del lenguaje natural en particular.

Sin embargo, opto por ser optimista y, si se han conseguido avances tan espectaculares en los últimos años, no veo razón para que no se puedan llegar a superar estas problemáticas, quizá evolucionando la arquitectura transformer, quizá con una nueva arquitectura o a lo mejor, en algún caso, con nuevos modelos de trabajo.

Es y va a ser apasionante ver cómo se avanza en este campo.