La Universitat Jaume I (UJI) de Castellón presenta los resultados del estudio europeo EYESHOTS donde se ha intentado replicar en robots los comportamientos humanos relacionados con la visión, el agarre de objetos y la percepción espacial. En él han participado neurocientíficos, psicólogos, ingenieros y expertos en inteligencia artificial.

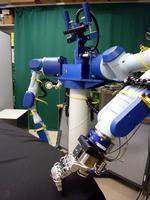

El autómata de Laboratorio de Robótica Inteligente de la UJI, que ha participado en el proyecto EYESHOTS. Imagen: RUVID

Tras tres años de trabajo, el equipo del proyecto EYESHOTS (Heterogeneous 3-D Perception Across Visual Fragments) ha logrado avanzar en la interacción entre el control de la visión y el movimiento de un robot, y desarrollar un avanzado sistema visual tridimensional que se sincroniza con los brazos y que permite a la máquina percibir, tomar conciencia de lo que le rodea y además recordarlo para actuar en consecuencia.

En el proyecto, financiado por la Unión Europea a través del 7º Programa Marco y coordinado por la Universidad de Génova (Italia), han participado, además de la UJI, la Universidad Westfälische Wilhems (Alemania), la Universidad de Bologna (Italia), y la Universidad Católica de Leuven (Bélgica).

Para que un robot humanoide interaccione correctamente con su entorno y desarrolle tareas de manera autónoma, es necesario primero perfeccionar estos mecanismos básicos que todavía no están resueltas satisfactoriamente, indica el investigador Ángel Pasqual del Pobil, director del Laboratorio de Robótica Inteligente de la Universitat Jaume I (UJI) de Castellón. Han validado sus conclusiones con un sistema oculomotor consistente en un cabeza de robot con ojos móviles integrado a un torso con brazos articulados construido en la Universidad castellonense.

Los modelos computacionales se han basado en los conocimientos de la biología animal y humana, para lo cual se han unido expertos en neurociencias, psicología, robótica e ingeniería. El estudio del control de la visión se inició registrando las neuronas de monos dedicadas a la coordinación visomotora, ya que nuestra forma de percibir el mundo la compartimos con los primates que poseen un sistema visual similar al nuestro.

La primera característica de nuestro sistema visual que se quería replicar de manera artificial es el movimiento sacádico de los ojos relacionado con el cambio dinámico de atención. Según Ángel del Pobil, “constantemente cambiamos el punto de vista con rápidos movimientos de los ojos, tanto que nosotros casi no somos conscientes. Cuando los ojos están en movimiento, la imagen es borrosa y no somos capaces de percibirla nítidamente, de modo que el cerebro integra los fragmentos como si se tratase de un puzle para darnos la impresión de una imagen continua y perfecta del entorno”.

Se aprende a base de conectar neuronas

A partir de los registros neuronales se hicieron modelos computacionales de la parte del cerebro que integra las imágenes con los movimientos tanto de ojos como de brazos. La hipótesis de fondo es que esa integración es muy diferente de como se suele realizar en ingeniería o robótica y la representación de la información también difiere. En este sentido, los expertos intentaron demostrar que cuando las personas hacemos un movimiento de alcance hacia un objeto, el cerebro no calcula las coordenadas, sino que el brazo sabe dónde tiene que ir porque se lo ‘dicen’ los ojos.

“No es que a partir de los ojos, el cerebro calcule una posición y entonces el brazo se mueva a esa posición, sino que es mucho más directo: al mirar los ojos a un punto, los ojos le ‘dicen’ al brazo dónde tiene que ir. Todo esto se va aprendiendo durante las etapas de desarrollo: los bebés no conocen esa relación pero se aprende a base de conectar neuronas”, explica el investigador.

Estos mecanismos de aprendizaje se han simulado en EYESHOTS a partir de un modelo computacional de redes neuronales consistente en aprender a mirar, construir una representación del entorno, conservar las imágenes adecuadas y utilizar la memoria para alcanzar objetos con la mano aunque no se estén observando en ese momento.

Se trata, por tanto de un proyecto de investigación más básica que aplicada. “Nuestros hallazgos se pueden aplicar a cualquier robot humanoide del futuro con capacidad de mover los ojos y enfocarlos a un punto. Son cuestiones prioritarias para que los demás mecanismos funcionen correctamente”, puntualiza el investigador.

El Laboratorio de Robótica Inteligente trabaja de manera paralela en el proyecto europeo GRASP centrado en el agarre robótico, es decir, en la manipulación de objetos distintos. El objetivo es demostrar que el prototipo de robot logra vaciar una cesta de la compra con objetos de diferente tamaño y forma sin que se caigan y colocarlos ordenadamente en otra ubicación. Es otra de las cuestiones fundamentales de la robótica que estos investigadores intentan resolver.

Artículo publicado en Servicio de Información y Noticias Científicas (SINC).