Los ordenadores de hoy nacieron como supercomputadoras en el pasado. Todos esos conceptos de arquitectura de familia, multinúcleo, operaciones de coma flotante por segundo, son fruto de una investigación azarosa en los años 60.

En abril de 1964 IBM presentaba su microprocesador S/360. Un año después, el equipo de Control Data Corporation hizo lo propio con su modelo 6600, primer superordenador de la historia. Ambos marcaron el devenir de estos monolitos gigantescos, monstruos de la computación con una meta central: optimizar el tiempo que tarda una CPU en hacer un cálculo.

En España presume el MareNostrum. Una hora de cálculo de esta supercomputadora equivale a 6 años de trabajo con un ordenador convencional. ¿Para qué necesitamos esto? Para cualquier actividad que requiera miles de operaciones por segundo: desde predicción meteorológica a simulación en el comportamiento de bacterias que, de otra forma, nos llevaría años estimar. De esta forma se puede innovar y progresar en campos de investigación donde los plazos son absolutamente claves.

¿Cuánta potencia necesita mi PC para ser llamado supercomputador?

Demasiado para costearlo y meterlo en casa. Titan, por ejemplo, el segundo súperPC más potente del mundo, ocupa 404 m2 y costó casi 100 millones de dólares.

En primer lugar, hay que apuntar que estos sistemas no se componen de un único hilo de procesamiento de datos. Son granjas enteras de CPU interconectadas mediante nodos, trabajando de forma conjunta. Aquí está la virtud de estos sistemas: su rendimiento se multiplica exponencialmente.

MareNostrum, situado en el Centro Nacional de Supercomputación en Barcelona, dispone de una capacidad de cálculo de 110 billones de operaciones por segundo (1,1 PetaFLOPS). Se compone de 48.896 procesadores Intel Xeon de 64 bits a 2,6 GHz de velocidad y 95,5 TiB de memoria, según su última revisión en noviembre de 2015. «Cada ordenador tiene lo que llamamos dos sockets (zócalos de conexión) y cada socket tiene 8 CPU», apunta Jordi Torres.

Una hora de cálculo del MareNostrum equivale a 6 años de trabajo con un ordenador convencional

Su capacidad de almacenamiento tampoco está nada mal: 2 Petabytes —dos millones de gigas dispuestos en discos rígidos de 1 TB a 720 rpm—, suficiente para alojar las fotos de muchas vacaciones. De hecho, el peso de Internet Archive es aproximadamente el mismo. El sistema operativo la distribución SuSe, de Linux. Linux, por cierto, es el núcleo-OS más habitual en supercomputadores: un 98.8%, concretamente 494 de la lista de los 500 más potentes, lo utilizan.

La ambición en España tampoco se ha quedado estancada con el MareNostrum: a las actualizaciones periódicas le sigue el proyecto MareIncognito, parte de una red a nivel europeo que pretende marcar nuevos estándares. Se espera que MareIncognito alcance el orden de los 10 PetaFLOPS, entrando en la lista de los 5 superordenadores más potentes del mundo. MareNostrum ostenta actualmente la posición 93.

Mira todo lo que se puede hacer con 1 PetaFLOP

Info

Create bar charts

Uno de los pilares del progreso pasan por tener superordenadores punteros

Nuestro MareNostrum tiene una lista de tareas muy específica: en base a la importancia y duración de los estudios, así se prioriza su uso. «Esto nos permite atacar problemas de genómica, por ejemplo; las simulaciones que se realizan aquí permiten un tiempo razonable para que los biólogos puedan sacar conclusiones y volver a hacer experimentos», explica Jordi Torres, profesor e investigador del BSC–CNS.

La supercomputación tuvo un agresivo repunte hace algunos años. Desde entonces ha caído en cierto ostracismo en los medios debido a nuevos conceptos como cloud computing o, más recientemente, fog computing. Pero las posibilidades teóricas de un sistema como el MareNostrum son prácticamente infinitas. No en vano La Casa Blanca ha entendido que uno de los pilares del progreso pasan por tener superordenadores punteros. EE. UU. quiere recuperar el liderazgo y, aunque lo ha perdido a favor de China y sus gigantescos sistemas conectados, ostenta 5 de los 10 primeros puestos en la famosa lista del Top500.

Las supercomputadoras ofrecen respuestas a los ingenieros de campos dispares en un espacio de tiempo ínfimo

Sí, la NASA no puede vivir sin ellos. Desde la exposición de las bacterias en entornos controlados, los sistemas de cultivo, rutas de asteroides, simulaciones de explosión de supernovas en el espacio, el riesgo del viento solar, aerodinámica, el modelado de proteínas y cómo estas afectan en enfermedades como el Alzheimer, cómo se comporta la radiación del samario sobre los tejidos cancerosos o hasta los modelos 3D de estudios sobre densidad de población, las supercomputadoras ofrecen respuestas en plazos cortos a los ingenieros de campos dispares, dando la oportunidad de actuar a tiempo, de encarar el futuro con una valiosísima información.

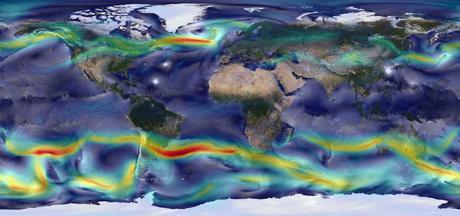

Estudiando el cambio climático

El eterno demonio del siglo XXI, el mayor generador de debates, del Nobel por las investigaciones de Al Gore, del oscuro futuro que se avecina a uno presuntamente mucho más verde. En el Centro Nacional para la Investigación Atmosférica (NCAR) de Estados Unidos, el nuevo superordenador Cheyenne estudia, mediante millones de mediciones, los posibles efectos del calentamiento global a largo plazo.

Gracias a los datos que arroja —como que en 2050 el cambio climático produciría medio millón de muertes en adultos— se definen los lugares donde deben situarse los pulmones para enfriar las ciudades, se conforma un simulador forestal 3D o se estudia hasta dónde podría aumentar el nivel del mar —de 51 a 130 cm hacia 2100— , de manera dinámica.

Igual sucede con la peligrosidad o durabilidad de agentes contaminantes. Por ejemplo, en este artículo se citaba la importancia de nuevos materiales como el grafeno. Pues bien, para determinar la posible polución en el territorio a largo plazo de estos elementos, una vez liberados en la naturaleza, se utilizan simulaciones que requieren miles de cálculos. Estos estudios comparten una idea común: mejorar la vida de las personas, simple y llanamente.

Igual sucede con la peligrosidad o durabilidad de agentes contaminantes. Por ejemplo, en este artículo se citaba la importancia de nuevos materiales como el grafeno. Pues bien, para determinar la posible polución en el territorio a largo plazo de estos elementos, una vez liberados en la naturaleza, se utilizan simulaciones que requieren miles de cálculos. Estos estudios comparten una idea común: mejorar la vida de las personas, simple y llanamente.Procesar sin almacenar

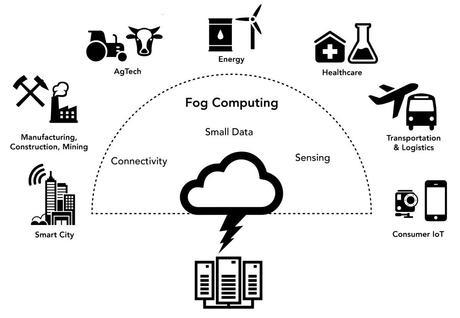

No se trata sólo de potencia bruta, de datos técnicos sobre el papel midiéndose las fuerzas. El tiempo de respuesta es clave para atajar los problemas. Y de ahí que las supercomputadoras trabajen de manera híbrida. «Los datos se procesan en el mismo sitio donde se están tomando y así se puede ya tomar decisiones», comenta Jordi Torres.

La idea, explicado de manera sencilla, es proveer de respuestas al sistema que hace las preguntas sin pasar por un ordenador central que coordine todos los datos. De esta forma conseguimos que, a través de pequeños sistemas satelitales conectados, arrojen las respuestas que buscamos sin dar toda la vuelta hasta retornar a la fuente, ahorrando esos milisegundos que hace que aplicaciones y procesadores sean cada vez más rápidos y eficientes.

Ya no se almacena todo porque es imposible. Google procesa en torno a 20 petabytes de datos diarios. Este modelo, que no es otro que el fog computing, nace a partir del internet de las cosas —electrodomésticos inteligentes, wearables, coches conectados, etcétera—: se pretende utilizar el mismo aparato para compilar, generar y responder a esos datos, aliviando así a la nube de parte del trabajo. Un sistema que emula con inteligencia, en cuanto a análisis de datos, a la propia forma de encarar la información que recibe nuestro cerebro.

Ya no se almacena todo porque es imposible. Google procesa en torno a 20 petabytes de datos diarios. Este modelo, que no es otro que el fog computing, nace a partir del internet de las cosas —electrodomésticos inteligentes, wearables, coches conectados, etcétera—: se pretende utilizar el mismo aparato para compilar, generar y responder a esos datos, aliviando así a la nube de parte del trabajo. Un sistema que emula con inteligencia, en cuanto a análisis de datos, a la propia forma de encarar la información que recibe nuestro cerebro.Así se han logrado, algoritmos mediante, permitir que una máquina aprenda a escribir artículos a partir de datos recopilados, campeones mundiales en juegos, desde Deep Blue hasta el multipremiado Alpha Go de Google, creación procedural en videojuegos o el diseño de Inteligencias Artificiales cada vez menos artificiales.

La economía del tiempo

«El principal problema del mercado financiero es la velocidad de la luz». Esta poderosa frase se escondía entre las páginas de ‘Ritual de muerte’, novela de Warren Ellis. Tal vez suene demasiado ficcional pero esconde una realidad latente: en la Bolsa, el principal factor de choque es el tiempo. Las cuentas se miden por el timing. El tiempo y la distancia lo es todo para definir un cierre al borde del abismo o un montón de accionistas celebrando, desde sus casas, un aumento tremendo en sus inversiones.

La novela hacía referencia a la intermediación bursátil de alta frecuencia. Se trata simplemente de programas informáticos que invierten según la recopilación de datos de los mercados y se benefician de la velocidad en cuanto a transmisión de órdenes —con la que no podría competir ningún broker—. De hecho, esto es algo sólo disponible para las propias firmas de valores, quienes tienen acceso directo a los superordenadores centrales.

Y no sólo para estimar y prevenir. Un ejemplo real: la prospección de petróleo en el Golfo de México, donde el poder extraer bolsas de petróleo que están debajo de 3.000 metros de agua, que cuesta una verdadera fortuna, se logre de manera efectiva, optimizando el rendimiento en tiempo, inversión y trabajo y minimizando los riesgos.

Y no sólo para estimar y prevenir. Un ejemplo real: la prospección de petróleo en el Golfo de México, donde el poder extraer bolsas de petróleo que están debajo de 3.000 metros de agua, que cuesta una verdadera fortuna, se logre de manera efectiva, optimizando el rendimiento en tiempo, inversión y trabajo y minimizando los riesgos.El propio Jordi Torres señala «estos superordenadores hacen un mapa del subsuelo y a partir de este mapa vas a saber dónde están, y puedes hacer una extracción». Ya que el tiempo nunca se detiene, ordenadores como el MareNostrum logran esa paradoja de ahorrarnos años de trabajo con apenas unas horas de cálculo. «El tiempo es la cosa más valiosa que una persona puede gastar», que diría el filósofo Teofrasto.

Contenido ofrecido por