Continuamos con la pequeña serie de artículos dedicados a metodología relacionada con el Machine Learning.

Continuamos con la pequeña serie de artículos dedicados a metodología relacionada con el Machine Learning.Hoy hablamos de SEMMA. SEMMA fue creada por el SAS Institute en 2012 y en ese sentido precede a CRISP-DM, con la que abrimos esta serie de artículos y en la que también participó SAS (hoy en IBM).

Como CRISP-DM, más que como una metodología de Machine Learning, se plantea como una metodología (o al menos un proceso) para Data Mining, antecedente del Machine Learning, pero sus propuestas pueden seguir siendo bastante válidas en el contexto algo más amplio, al menos en mi opinión, del Machine Learning.

El SAS Institute define Data Mining como

the process of Sampling, Exploring, Modifying, Modeling, and Assessing (SEMMA) large amounts of data to uncover previously unknown patterns which can be utilized as a business advantage.

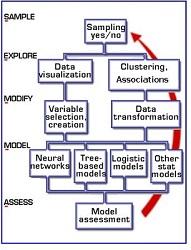

definición en la que ya podemos ver que aparece el acrónimo SEMMA porque, en efecto, SEMMA lo que establece es un proceso que incluye esas cinco fases, a saber:

definición en la que ya podemos ver que aparece el acrónimo SEMMA porque, en efecto, SEMMA lo que establece es un proceso que incluye esas cinco fases, a saber:- 'Sample' (muestreo): es decir, captura de datos y eventualmente creación de tablas u otras estructuras que los contengan, y prestando atención al tamaño de las muestras de manera que el conjunto de datos sea suficientemente grande para que resulte representativo y suficientemente pequeño como para permitir el procesamiento.

- 'Explore' (exploración): entender de alguna forma los datos de que se dispone mediante visualización, agrupamiento, etc de forma que se puedan observar relaciones, tendencias y cualquier otra información que nos de una idea general sobre los datos y el fenómeno subyacente.

- 'Modify' (modificación): Trabajo sobre los datos de forma que queden listos para el posterior modelado. Eso se consigue realizando pequeñas transformaciones, seleccionando variables e incluso creándolas a partir de datos en bruto, etc

- 'Model' (modelado): quizá la etapa más científica y valiosa (aunque no necesariamente la que más tiempo consume) en donde se determina el modelo más adecuado (el que mejor predice la o las variables de salida a partir de la o las variables de entrada), seleccionando entre las familias disponibles (redes neuronales, árboles de decisión, regresión logística, etc) y afinando el modelo en la o las opciones seleccionadas.

- 'Assess' (evaluación): Evaluar el funcionamiento del modelo en su conjunto en cuanto a fiabilidad, utilidad etc

Como se puede observar, se trata de un proceso definido a muy alto nivel, que no se diferencia demasiado de los que hemos visto hasta ahora (especialmente del CRISP-DM) y que, en gran medida es puro sentido común o conocimiento básico de la mecánica de trabajo con datos.

Artículos de este blog relacionados

- Metodología para Machine Learning (II): Machine Learning Canvas

- Metodología para Machine Learning (I): CRISP-DM