Damos un nuevo paso en estas notas sobre aprendizaje por refuerzo siguiendo, como en toda esta ya larga serie, el libro 'Deep reinforcement learning' de Aske Plaat.

Damos un nuevo paso en estas notas sobre aprendizaje por refuerzo siguiendo, como en toda esta ya larga serie, el libro 'Deep reinforcement learning' de Aske Plaat.A partir de ahora, eso sí, iré un poco más rápido, sobrevolando más los temas para no complicar demasiado los artículos y no alargar en exceso esta serie, que ya debería irse acernado a su fin.

En este artículo, en concreto, comentaré las ideas principales de una forma de aprendizaje que se centra en el modelo de transiciones del entorno.

Pero antes, y como ya viene siendo habitual, repasemos lo principal que hemos visto hasta ahora

Recordatorio: resumen lo que hemos visto de aprendizaje por refuerzo

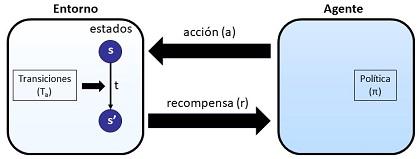

Recordamos el esquema que tantas veces hemos venido repitiendo:

Estamos ante la situación de un agente que interactúa con un entorno, un entorno que se encuentra en un estado s. Sobre ese entorno, el agente aplica unas acciones, a, como consecuencia de las cuales, el entorno puede experimentar una transición y cambiar de estado, pasando del estado s al s', y el agente recibe una recompensa r. El agente decide la acción a aplicar en cada momento, siguiendo una política π y su objetivo es maximizar la recompensa obtenida, no tanto en una única interacción, como siguiendo una secuencia o trayectoria.

Los métodos más básicos, aquellos en que el espacio de estado es reducido, siguen un enfoque tabular, en que se tabulan, de ahí el nombre, los posibles estados y para ellos se calculan unas funciones que nos dan el valor, Q, de la recompensa esperada.

Cuando la dimensión del espacio de estados es muy alta, como sucede habitualmente en problemas reales, dejan de tener sentido estos métodos tabulares así que renunciamos a representar la situación del entorno mediante su estado, y a cambio lo representamos mediante unas características ('features') y la obtención de valores o acciones vienen a ser unas funciones con base en esas características e implementadas mediante redes neuronales profundas, dando lugar al 'deep reinforcement learning'.

Cuando tratamos problemas ya no de alta dimensionalidad, sino continuos, como es la locomoción de robots, se adoptan los denominados métodos basados en políticas en que se prescinde de la visión de valores, y se trabaja directamente en optimizar las políticas, que pasan a considerarse como estocásticas, es decir, como distribuciones de probabilidad.

La idea del aprendizaje basado en modelos

Los modelos vistos hasta ahora eran lo que se denomina 'model-free', o sin modelo, en el sentido que el agente busca optimizar la política π pero lo hace directamente, sin 'intentar entender', por decirlo de alguna manera, cómo funciona el entorno con el que interactúa, sólo basándose en el 'feedback' que recibe de ese entorno en forma de recompensas.

Ese 'entender' se referiría a estimar y construir un modelo de las transiciones (T) del entorno

La forma de actuar sin modelo, como hemos visto hasta ahora, tiende a conducir en la práctica a un entrenamiento lento y que puede precisar de millones de muestras para converger.

Por ello surgen los métodos basados en modelos ('model-based').

En estos métodos, el agente primero construye localmente, y a partir del feedback referido del entorno, un modelo sobre el entorno, un modelo de transiciones del entorno. Y, una vez que ya tiene ese modelo, puede, con él, estimar la consecuencia que tendrían sus acciones y las recompensas que obtendría. Sería algo así como hacer juegos del tipo 'que pasa si' ('what-if') y, en función de los resultados, actualizar su política.

A esa generación o actualización de políticas, con base en el modelo local del entorno, es a lo que se llama planificación o 'imaginación'. Me permito solicitar al lector que se fije en lo que realmente hablamos al hablar de imaginación en estas situaciones, para evitar fantasías sobre las capacidades de la inteligencia artificial.

Como se puede ver, este tipo de métodos actualizan la política de una forma indirecta: primero aprenden un modelo local del entorno, a partir de la interacción con ese entorno, y luego usan ese modelo del entrono para actualizar la política, que es el objetivo final.

Como una forma sencilla de recordar la diferencia entre los métodos sin modelo y los basados en modelo, podríamos guardar esta frase de Plaat

Model-free teaches you how to best respond to actions in your world, and model-based helps you to understand your world.

Actuar como lo hacemos en los métodos con modelo, tiene dos consecuencias, una positiva y una negativa. La consecuencia positiva es que, una vez que el agente ha construido el modelo local del entorno, ya no necesita interactuar más con él para optimizar su política, sino que lo hace 'de gratis', por decirlo de alguna manera, exhibiendo, pues, menor complejidad en el muestreo. A cambio, y como riesgo, o como consecuencia negativa, pueden conducir a baja precisión en el modelo del entorno y, en consecuencia, a una política de baja calidad.

Algunos métodos basados en modelo, que se mencionan en la obra citada, son el Dyna-Q, redes de predicción de valores ('value prediction networks') y redes de iteración de valores ('value iteration networks').

Conclusiones

Cuando supone un problema el tener que tomar demasiadas muestras del entorno, o cuando es un inconveniente serio la velocidad de convergencia, una alternativa son los métodos basados en modelo en que el agente primero construye un modelo local del funcionamiento del entorno (sus transiciones) y, a partir de ahí, interactuando con ese entorno local, en lugar de hacerlo con el real, optimiza su política.

Artículos de este blog relacionados

- Notas sobre aprendizaje por refuerzo (X): locomoción de robots

- Notas sobre aprendizaje por refuerzo (IX): aprendizaje de políticas y el ascenso de gradiente

- Notas sobre aprendizaje por refuerzo (VIII): problemas continuos y métodos basados en políticas

- Notas sobre aprendizaje por refuerzo (VII): El triunfo del algoritmo DQN (Deep Q-Network)

- Notas sobre el aprendizaje por refuerzo (VI): los tres retos del deep reinforcement learning

- Notas sobre el aprendizaje por refuerzo (V): deep reinforcement learning

- Notas sobre aprendizaje por refuerzo (IV): Métodos tabulares. SARSA Y Q-Learning

- Notas sobre aprendizaje por refuerzo (III): recompensas, trazas y valores

- Notas sobre aprendizaje por refuerzo (II): Visualizando el aprendizaje en procesos de Markov

- Notas sobre aprendizaje por refuerzo (I): Procesos de decisión de Markov