Este post Optimiza tu web de la mejor manera: Screaming Frog – Primera Parte 🤓 aparece primero en Asnet Soluciones Informáticas.

Screaming Frog Seo Spider es una herramienta indispensable para aquellos que estén en el mundo del SEO y les interese optimizar al máximo su web.

Esta herramienta nos ofrece la posibilidad de poder rastrear todas nuestras URLs y encontrar fallos On Site.

Te vamos a contar como has de configurar ésta potente herramienta.

Sabemos que estás empezando 😊, así que no vamos a exponer todo de golpe, sino que vamos a ir paso a paso y en varias artes para no perdernos.

Eso si, como primer paso primordial: descárgate el programa.

1. Abrimos y…¡configuramos!

Lo primero que vamos a ver en nuestro panel, es una pequeña ventana donde pondremos nuestra URL y la escanee.

Pero antes de hacerlo debemos configurar algunos parámetros para poder optimizar mucho mejor y obtener lo que necesitas a la hora de auditar una web.

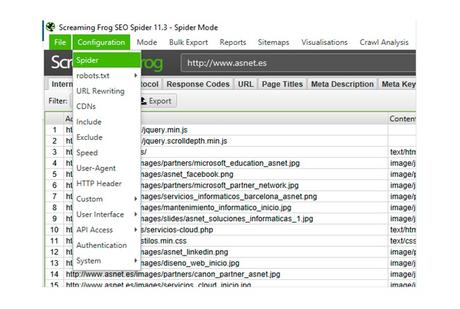

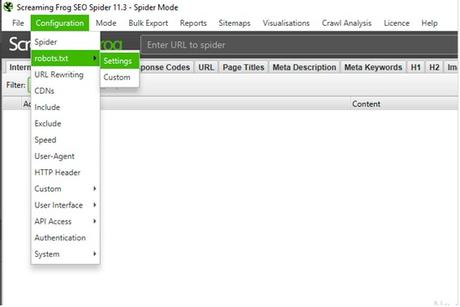

Si vas al menú en Configuration, veras varias opciones. ¡Vamos a verlas!

Configuracion Spider

Configuracion Spider

1.1 Spider

Una de las primeras opciones que nos sale en nuestro panel de configuración, podremos especificar qué tipos de archivos queremos rastrear, qué información y cómo.

Al clikcar nos saldrán las siguientes opciones con varias sub-pestañas: Basic – Limits – Rendering – Advanced – Preferences.

Vamos a ver las opciones de cada una de ellas.

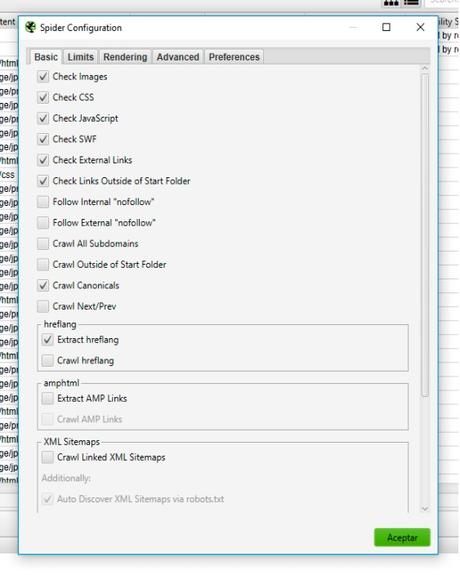

1.1.1 BASIC

Spider configuration pestaña Basic

Spider configuration pestaña Basic

En el primer apartado, Basic, nos proponemos seleccionar aquellos formatos que queremos rastrear.

Podemos incluir todo tipo de archivos: imágenes, CSS, Javascript, etc…

Podemos seleccionar los enlaces que queremos que siga: internos o externos que contengan NoFollow.

Hay una opción que se llama “Crawl All Subdomain’s” el cual, podrá tratar un subdominio como enlace interno y no externo.

También si en tu proyecto quieres comenzar el rastreo de tu Site por una URL que no sea la raíz, tendrás que marcar la opción “Crawl Outside of Start Folder”, como su propio nombre indica 😊.

Os aconsejamos dejar las opciones que vemos por defecto, ya que al dejarlas marcadas, extraerá la información que le hemos pedido con la URL como canónica, además de Hreflang o Next/Prev.

Si tenemos un Site muy grande, sería aconsejable desmarcar las imágenes, CSS, etc… para agilizar el proceso.

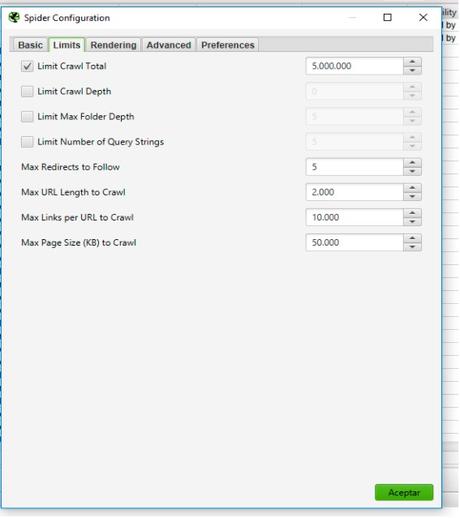

1.1.2 LIMITS

Spider configuration pestaña Limits

Spider configuration pestaña Limits

En ésta pestaña podremos limitar el rastreo, en el caso de que tengamos una web extensa.

- Limit Crawl Total: límite de URL por rastrear.

- Limit Crawl Depth: el nivel de profundidad máximo. Esto significa la cantidad de enlaces que sacaría desde el nivel que le indicamos. Los niveles son los clicks necesarios para extraer los enlaces.

- Limit max folder Depth: Es igual que el anterior, pero específico para directorios. Esto es ideal para webs tipo SILO y excluir las que estén por encima y quedarte URLs más simples como las de categorías por ejemplo.

- Limit number of Query Strings: Limita el número de parámetros con formato especial ?X= muy útil si rastreamos ecommerce.

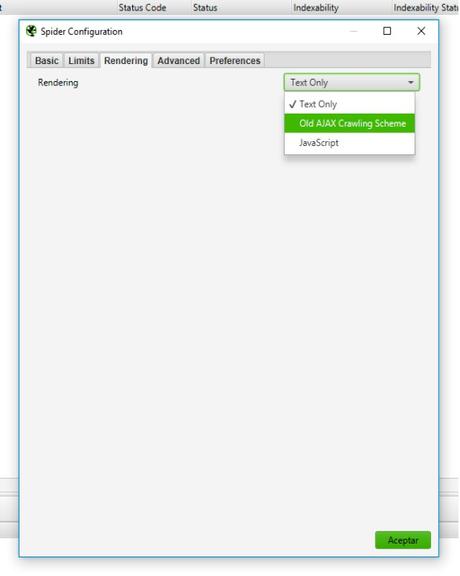

1.1. 3 RENDERING

Aquí podremos marcar si queremos que nos procese la página por Javascript o no.

Spider configuration pestaña Rendering

Spider configuration pestaña Rendering

Por defecto viene Text Only, que éste podría ser adecuado en el caso que tengamos elementos Javascript que puedan bloquear el rastreo al programa, pero os aconsejamos que seleccionéis Old Ajax Crawling Scheme y éste emulará un sistema de Google que permite rastrear contenido AJAX.

La opción de Javascript lo ejecutará en el caso de que lo tengamos en la web.

Ésta opción ralentizará a la “rana” ya que tardará en completar el proceso.

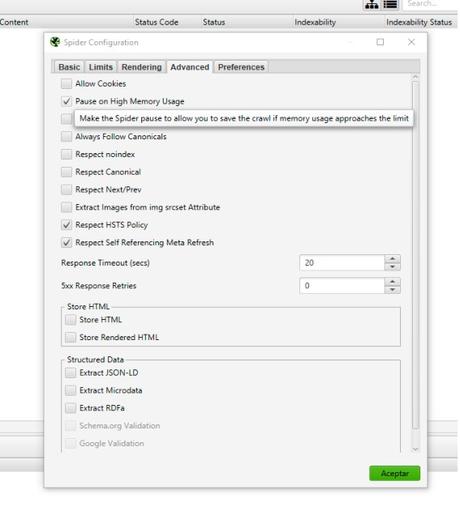

1.1.4 ADVANCED

Spider configuration pestaña Advanced

Spider configuration pestaña Advanced

Por defecto tenemos seleccionado: Pause on hight memory usage, y esto nos generará una pausa y un aviso para guardar nuestro proyecto cuando llegue al límite de uso memoria.

Esto puede suceder en páginas muy densas.

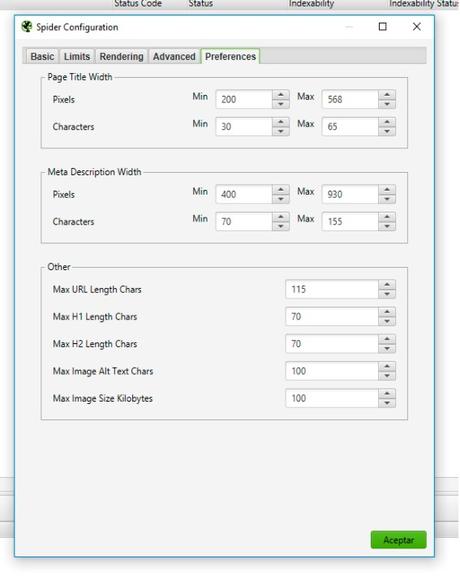

1.1.5 PREFERENCES

En éste apartado de panel, Screaming Frog te determina cuáles son las preferencias para él en cuanto Title, Meta, etc…

Si a ti te parece mucho o poco o sigues otro tipo de criterio y no quieres que te salga ningún error por esto, puedes adaptarlo a tus preferencias 😊.

Spider configuration pestaña Preferences

Spider configuration pestaña Preferences

1.2 Súper “robots.txt”

Pantalla Configuración Robots

Pantalla Configuración Robots

Tenemos dos subpestañas: settings y custom.

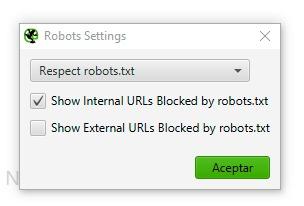

1.2.1 Settings

Para configurar el robots.txt, volvemos a la pestaña de configuración / robots.txt / Settings y tendremos dos opciones muy específicas:

Robots.txt. configuración Screaming Frog

Robots.txt. configuración Screaming Frog

Mostrar las URLs internas bloqueadas de robots.txt o las URLs externas.

Recomendamos dejar la marcada por defecto para verificar que estás haciendo lo que deseas.

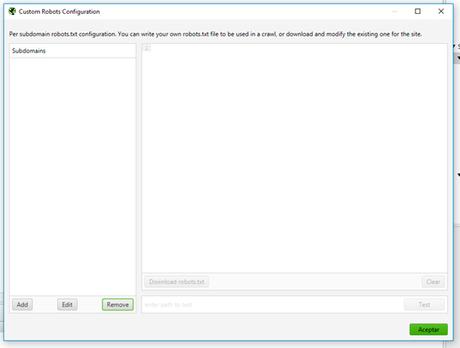

1.2.2 Custom

Podrás simular y hacer pruebas en éste panel. Añades la URL en add domain y podrás ver errores o rectificar, etc…Pero ten en cuenta que esto no modificará tu archivo real en robots.txt:

Screaming Frog Spider Custome Robots.txt

Screaming Frog Spider Custome Robots.txt

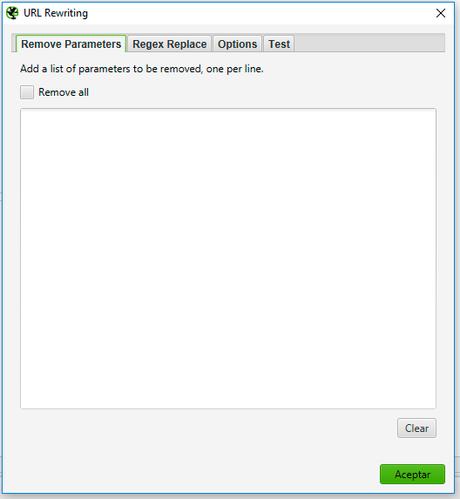

1.3 URL Rewriting:

Ésta opción avanzada te permite modificar las URLs y su sintaxis así como eliminar parámetros no deseados en su sintaxis.

Reescribe las URLs que modifiques.

Podremos testear y ver como queda nuestras nuevas URLs.

Screaming Frog Spider Robots.txt

Screaming Frog Spider Robots.txt

En la segunda parte de nuestro artículo os mostraremos como exprimir, usar y configurar Screaming Frog SEO Spider, os explicaremos los apartados que nos faltan, pero de momento….¡a testear, probar y configurar!

Este post Optimiza tu web de la mejor manera: Screaming Frog – Primera Parte 🤓 aparece primero en Asnet Soluciones Informáticas.