¿Puede un robot ser considerado un agente moral? No es una pregunta baladí, dadas sus implicaciones éticas e, incluso, legales (ligada al concepto de responsabilidad o 'liability').

¿Puede un robot ser considerado un agente moral? No es una pregunta baladí, dadas sus implicaciones éticas e, incluso, legales (ligada al concepto de responsabilidad o 'liability'). Veamos alguna idea al respecto.

El concepto de agencia moral

La idea de la agencia moral, o de los agentes morales es un concepto filosófico que, siguiendo la definición de la wikipedia, sería, la capacidad de un individuo para emitir juicios morales basados en alguna noción de lo correcto y lo incorrecto y ser responsable de estas acciones.

O, dicho de otra forma, un agente moral es un ser que es capaz de actuar con referencia al bien y al mal.

Aunque, como casi en cualquier cuestión filosófica existen corrientes y opiniones, en general tenemos pocas dudas de que un ser humano es un agente moral. No tan clara es la respuesta si eso lo referimos a animales y menos, aún, y eso voy en este artículo, si de lo que hablamos es de agentes artificiales, básicamente a robots.

Con frecuencia, el debate acerca de la agencia moral surge en las obras que hablan de ética de máquinas, de ética de los robots o, incluso, de relación robots-personas.

El último punto en que me lo encuentro es leyendo el libro 'The robot will see you now' editado por John Wyatt y Stephen N. Williams. En un capítulo que firma Noreen Herzfeld, se razona sobre si la inteligencia artificial debería contemplarse como una herramienta, un sustituto de personas o incluso un compañero o pareja. Y es bajo ese prisma que se vuelve a la idea de la agencia moral.

Se hace notar, lo primero, que la agencia implica intención e independencia.

Agency connotes intention or independence an agent's action stems from a choice or volition internal to the actor.

Los tres criterios de agencia moral

Susan Leigh Anderson y Michael Anderson

Y luego se hace mención al trabajo de Michael Anderson y Susan Leigh Anderson y su libro 'Machine Ethics', donde estos dos autores, identifican tres criterios que una entidad, en este caso un robot, debería satisfacer para ser considerado un agente moral:- El robot no debería estar bajo el control directo de ningún otro agente o usuario.

- La interacción del robot con su entorno debería ser aparentemente calculada y deliberada

- Debería satisfacer algún tipo de rol social que implique responsabilidades.

¿Puede cumplir los robots actuales esos criterios.

Se nos aporta el razonamiento sobre un robot usado para el cuidado de ancianos, algo que ya se está haciendo. Se razona que esos robots no actúan bajo supervisión directa, es decir, cumplen el primer criterio. Se concluye, asimismo, que en su labor, el robot toma decisiones o realiza elecciones y, en ese sentido, cumpliría el segundo criterio. Sin embargo, con respecto al tercer criterio se entiende que el robot debería ser consciente de su responsabilidad para con el paciente, el anciano en este caso. Y ese criterio no es satisfecho por ningún robot actual y quién sabe si podrá ser satisfecho alguna vez por un robot futuro.

Según ese razonamiento, un robot cuidador de ancianos (en realidad, ningún robot actual) no sería un agente moral.

El problema de la consciencia

Hago simplemente un apunte para finalizar. Según los tres criterios y la forma de aplicar el tercero, parece necesaria una consciencia en el robot, algo que parece muy lejano, suponiendo que sea posible, aunque, como veremos en nuestro próximo post ya hay trabajo intentando crear mentes robóticas y alguna suerte de consciencia.

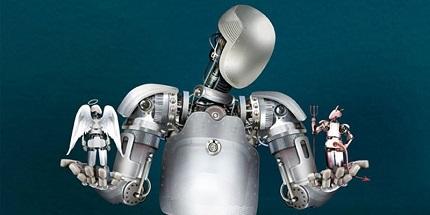

Foto de cabecera: 'Morals and the Machine' Derek Bacon en 'The Economist'