La moderación de contenidos en línea no siempre fue una cuestión partidista. Eso empezó a cambiar en 2016.

A principios del año pasado, en medio de las crecientes críticas de que las redes sociales estaban difundiendo desinformación sobre el covid-19, Facebook amplió una campaña sin precedentes para vigilar las falsedades, prohibiendo lo que denominó "afirmaciones desacreditadas" sobre el virus. Entre ellas: La afirmación de que el covid estaba "fabricado por el hombre" y se había filtrado desde un laboratorio de Wuhan, China.

Para el gobierno de Biden y la comunidad científica, los esfuerzos de Facebook por frenar la desinformación fueron demasiado escasos y tardíos, dado que su red había contribuido a que las afirmaciones falsas y perjudiciales se hicieran virales en primer lugar. Pero otros se quejaron de que las medidas represivas aplastaron el debate legítimo sobre la frustrante actuación de las autoridades de salud pública, una opinión que se reivindicó en parte cuando la falta de transparencia de China hizo que destacados científicos declararan "viable" la teoría de las fugas de los laboratorios y exigieran una mayor investigación.

En mayo de 2021, apenas tres meses después de imponer la prohibición, Facebook dio marcha atrás: "A la luz de las investigaciones en curso sobre el origen del Covid-19 y en consulta con expertos en salud pública", dijo la compañía, "ya no eliminaremos de nuestras aplicaciones la afirmación de que el Covid-19 es fabricado por el hombre."

Lo que la gente puede y no puede decir en Internet -y el papel de las grandes empresas tecnológicas en la toma de decisiones- se ha convertido en una línea de fractura crítica en la política estadounidense. La izquierda reclama la moderación de los contenidos para frenar la desinformación, el racismo y la misoginia. La derecha lo tacha de censura y exige el derecho a la libertad de expresión.

En los últimos meses, varios puntos álgidos han puesto de manifiesto esta batalla. La semana pasada, el Tribunal Supremo accedió a escuchar un caso que acusa a YouTube de instigar el terrorismo al recomendar contenidos del Estado Islámico. El mes pasado, un tribunal federal respaldó una ley de Texas que impide a las plataformas de redes sociales eliminar o limitar las publicaciones en función de su punto de vista político.

Mientras tanto, el hombre más rico del mundo, Elon Musk, está presionando para cerrar un acuerdo que le daría el control exclusivo de Twitter, cuya decisión de prohibir el acceso al presidente Donald Trump tras el ataque al Capitolio de Estados Unidos el 6 de enero de 2021, ha resonado como el acto de moderación de contenidos más divisivo de la historia de Internet. Musk ha dicho que reincorporaría a Trump.

"Nos acercamos a un momento crucial para la expresión en línea", dijo Daphne Keller, que dirige el Programa de Regulación de Plataformas en el Centro de Política Cibernética de la Universidad de Stanford. "Las presiones políticas sobre la moderación de contenidos han aumentado enormemente".

La forma en que los foros en línea establecen y hacen cumplir las normas sobre lo que los usuarios pueden publicar no siempre fue tan divisiva. Cuando nació la Internet de los consumidores a mediados de la década de 1990, los legisladores de ambos partidos compartían el deseo de ver prosperar a las empresas tecnológicas estadounidenses. Ese consenso sobrevivió a las primeras batallas sobre la pornografía, la violación de los derechos de autor, las fotos de lactancia y la propaganda terrorista.

Pero como en tantos ámbitos de la sociedad estadounidense, las elecciones de 2016 marcaron el principio del fin de esa cortesía bipartidista.

Christopher Cox, antiguo congresista republicano de California, forma parte ahora de la junta directiva de Netchoice, un grupo de presión de la industria tecnológica que lucha contra la ley de Texas. Cox dijo que puede entender la frustración de los conservadores con algunas de las decisiones de las plataformas, que calificó de "abuso de poder".

Pero el remedio no es dar más poder sobre el discurso al Estado, argumentó. "Que los políticos ejerzan el control sobre el discurso político de otros es una receta muy peligrosa".

Proteger al tipo "pequeño"

En 1995, Cox ayudó a elaborar la disposición que allanó el camino legal para que los actuales gigantes de Internet moderaran la expresión en línea. En aquel momento, lo que estaba en juego era tan poco que los medios de comunicación nacionales apenas se dieron cuenta.

La Internet de los consumidores estaba floreciendo, con millones de estadounidenses que empezaban a conectarse a servicios como CompuServe, Prodigy y AOL. En la medida en que la mayoría de los legisladores consideraban la expresión en línea, su principal preocupación era limitar la disponibilidad de la pornografía para los menores.

Cox y el representante Ron Wyden (demócrata de Oregón) tenían una preocupación diferente. A principios de ese año, una sentencia por difamación contra Prodigy consideró que su intento de vigilar sus foros le hacía responsable del contenido de los usuarios. A Cox y Wyden les preocupaba que la sentencia ahogara la incipiente Internet.

Así que elaboraron un estatuto que daba a los proveedores de servicios en línea un amplio margen de maniobra para alojar, distribuir y moderar los contenidos publicados por los usuarios sin ser considerados responsables cuando publicaran algo ilegal. Formando parte de un proyecto de ley más amplio llamado Ley de Decencia en las Comunicaciones, llegó a ser conocido simplemente por su ubicación: Sección 230.

En una reciente entrevista con The Washington Post, Wyden, ahora senador, recordaba que veía a las empresas de Internet como "el pequeño", y quería darles margen para desarrollar sus tecnologías innovadoras sin que se vieran aplastadas por regulaciones de mano dura. Pensaba que darles la posibilidad de moderar sus propios sitios conduciría a una Internet más limpia y segura, sin necesidad de que el gobierno censure la expresión en línea.

Cox, en otra entrevista, añadió: "La cuestión es quién está al mando. Se van a tomar decisiones sobre el contenido de estos sitios web. ¿Debe encargarse el gobierno de ello? Hay todo tipo de razones por las que sería una mala idea. Está sujeto a todo tipo de abusos".

Las primeras decisiones de los tribunales interpretaron el artículo 230 de forma aún más amplia de lo que Cox y Wyden habían previsto, estableciendo una amplia inmunidad para los contenidos publicados por los usuarios. Esto preparó el terreno para el surgimiento de sitios como Yahoo, Google y MSN. Más tarde llegaron YouTube, propiedad de Google, y Facebook. Podían alojar, agregar y organizar grandes cantidades de contenido de los usuarios sin tener que preocuparse demasiado, desde el punto de vista legal, de si podía ser falso, hiriente o incluso peligroso.

El resultado fue un potente modelo de negocio que, en comparación con los medios de comunicación tradicionales, prescindía de los creadores de contenidos de pago en favor de los usuarios ordinarios no remunerados, y sustituía a los editores de pago por algoritmos de software diseñados para sacar a la luz los contenidos más relevantes, atractivos o tentadores.

Sin embargo, la Internet de los consumidores nunca fue una zona de libertad de expresión sin restricciones. Las plataformas más exitosas descubrieron pronto que debían establecer y hacer cumplir unas normas básicas o se verían invadidas por la pornografía, el spam, las estafas, el acoso y la incitación al odio, y eso sería malo para el negocio.

Incluso cuando un foro de Internet comienza con el objetivo de permitir un discurso libre, "rápidamente se encuentran con el hecho inevitable de que hay que moderar para tener un producto comercialmente viable y fácil de usar", dijo Evelyn Douek, una profesora de derecho de Stanford que investiga las regulaciones de la expresión en línea.

La necesidad de filtrar y revisar millones de publicaciones al día en sitios como YouTube y Facebook dio lugar a una industria en la sombra de moderación de contenidos comerciales en la que participan enormes equipos de trabajadores que se pasan el día tomando decisiones rápidas sobre la eliminación de publicaciones que los usuarios han marcado como ofensivas u obscenas. Para mantener la ilusión de una "zona de libertad de expresión", las empresas tecnológicas tienden a distanciarse de ese trabajo, y a menudo lo subcontratan a contratistas mal remunerados en lugares lejanos, dijo Sarah T. Roberts, autora de " Behind the Screen: Content Moderation in the Shadows of Social Media ".

Aun así, algunas decisiones resultaron ser demasiado espinosas o consecuentes para que las empresas tecnológicas las escondieran bajo la alfombra.

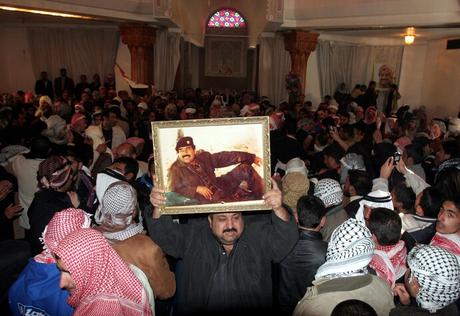

En 2006, un vídeo impactante apareció en el entonces nuevo YouTube: El vídeo, granulado y movido, mostraba al depuesto presidente iraquí Saddam Hussein siendo ahorcado por miembros del nuevo gobierno iraquí, algunos de los cuales gritaban insultos en sus últimos momentos. El ahorcamiento había sido cerrado a los medios de comunicación; el vídeo exponía una ejecución vengativa e indigna que contradecía los informes oficiales.

La decisión de dejar el vídeo o retirarlo recayó en la consejera general adjunta de Google, una joven abogada llamada Nicole Wong. "Lo que acabamos decidiendo fue que el vídeo de la ejecución era realmente un momento histórico, y que era realmente importante que se compartiera y se viera", dijo Wong en una conferencia de 2018.

Dos años más tarde, un grupo de madres protestó ante las oficinas de Palo Alto de la red social Facebook, de tres años de antigüedad, que había estado retirando fotos de lactancia materna por violar su norma contra la desnudez. El furor hizo que Facebook elaborara su primer reglamento interno sobre lo que los usuarios podían y no podían publicar, estableciendo distinciones precisas, aunque algo arbitrarias, para distinguir entre imágenes sanas y morbosas, entre otras cosas.

Las anteriores políticas de contenidos se reducían a " si te hace sentir mal, bájalo ", como dijo una vez la antigua responsable de seguridad Charlotte Willner. En una reciente entrevista con The Post, Willner recordó que una de las motivaciones que guiaban la falta de regulación de los contenidos en línea era el deseo de los ejecutivos de no entrar en conflicto con gente poderosa, especialmente con funcionarios públicos que pudieran intentar demandarlos o regularlos.

A pesar de los ocasionales enfrentamientos, las grandes plataformas cultivaron una imagen de guardianes de la libertad de expresión en el extranjero -un funcionario de Twitter se jactó en 2012 de que su empresa era " el ala de la libertad de expresión del partido de la libertad de expresión "- mientras mantenían una estudiada neutralidad política en casa.

Pero a medida que la influencia de las redes sociales en la política y las costumbres sociales ha crecido, se ha hecho más evidente que la libertad de expresión para algunos usuarios podría significar un daño real para otros.

En 2014, grandes subculturas de jugadores enfadados, en su mayoría hombres, atacaron a un puñado de mujeres de la industria de los videojuegos y de los medios de comunicación con amenazas en línea despiadadas y coordinadas, que a veces se convirtieron en ataques en el mundo real. Ese movimiento, conocido como GamerGate, puso en tela de juicio las pretensiones de neutralidad de las empresas tecnológicas, porque enfrentó las reivindicaciones de libertad de expresión de un grupo de usuarios con la privacidad y la seguridad de otros, dijo Tarleton Gillespie, investigador principal de Microsoft y autor del libro " Custodios de Internet ". La neutralidad, en este caso, significaba permitir que el acoso continuara.

La ilusión de la neutralidad de las redes sociales con respecto a la política partidista empezó a desmoronarse dos años después, con efectos que aún resuenan.

Noticias falsas e ira real

En mayo de 2016, el blog de tecnología Gizmodo publicó un artículo en el que se denunciaba que los empleados liberales de Facebook estaban suprimiendo en secreto las noticias de los medios de comunicación de derechas en la influyente sección de noticias "Trending" de la red social. Aunque dar prioridad a las fuentes de noticias de la corriente principal frente a los medios abiertamente partidistas podría parecer razonable para algunos, los conservadores lo vieron como un momento de "pillada" que demostraba que los gigantes tecnológicos de Silicon Valley estaban imponiendo sus valores liberales a sus usuarios.

El director general de Facebook, Mark Zuckerberg, se embarcó en una gira de disculpas de alto nivel, reuniéndose personalmente con los principales políticos y expertos conservadores, ordenando la formación en materia de sesgos para sus empleados y despidiendo a los periodistas encargados de la sección Trending.

Sin embargo, mientras el líder de la compañía se ocupaba de controlar los daños, su plataforma estaba siendo explotada de formas nuevas y preocupantes en el período previo a las elecciones presidenciales de noviembre de 2016 en Estados Unidos.

Una industria artesanal de sitios de noticias falsas, algunos dirigidos por adolescentes en Macedonia, estaba en auge en Facebook, ya que sus artículos fabricados -que a menudo tenían una inclinación pro-Trump- a veces recibían más likes y clics que los informes de noticias reales.

Después de la elección de Trump se supo que el lucro no era el único motivo de la avalancha de contenidos políticos manipuladores en Facebook. Los agentes rusos también habían estado utilizando cuentas, grupos y páginas falsas en la red social para difundir contenidos polarizantes destinados a enfrentar a los estadounidenses.

Los intentos de los empleados de Facebook de abordar tanto el problema de las noticias falsas como las operaciones de información rusas se vieron socavados, según informó posteriormente The Post, por el miedo de sus dirigentes a enfadar aún más a los conservadores.

En 2017, muchos en la izquierda habían llegado a culpar a Facebook y a las redes sociales por ayudar a elegir a Trump, presionando a las empresas tecnológicas para que adoptaran posturas más duras no solo contra las noticias falsas, sino contra las frecuentes falsedades y provocaciones racistas del propio presidente.

En respuesta, las empresas tecnológicas que antes se enorgullecían de su escaso personal, aceptando tácitamente cierta fealdad como el coste de hacer negocios, empezaron a gastar mucho en moderadores de contenidos humanos. Desarrollaron programas informáticos para ayudar a automatizar el proceso de marcar las publicaciones que pudieran infringir sus cada vez más complejas normas.

Mientras sus esfuerzos barrían las publicaciones incendiarias de los partidarios más fervientes de Trump, Facebook y Twitter se resistían a tomar medidas contra el propio Trump. En su lugar, inventaron varias exenciones ad hoc para permitirle seguir en la plataforma.

Las redes sociales también compartieron la culpa por el auge de un movimiento supremacista blanco más ruidoso y visible, que utilizó los foros en línea para radicalizar, reclutar y organizar eventos como la mortífera manifestación "Unite the Right" en Charlottesville en 2017. Para los liberales, eso reforzó el vínculo entre el discurso en línea y la violencia en el mundo real, haciendo que la moderación de contenidos fuera literalmente una cuestión de vida o muerte. Ese vínculo se hizo patente en 2018, cuando el discurso de odio y las mentiras sobre los musulmanes que se difundieron en Facebook contribuyeron a alimentar un genocidio en Myanmar contra la minoría rohingya del país.

Al mismo tiempo, la derecha desconfía cada vez más de los esfuerzos de las empresas tecnológicas por abordar esos problemas a nivel nacional, considerándolos censuradores y políticamente motivados. Las acciones de las plataformas contra las cuentas y grupos de derechas implicados en la violencia de Charlottesville impulsaron a la extrema derecha a empezar a crear sus propias redes sociales de "libertad de expresión", como el Gab de Andrew Torba.

En lo que desde entonces se ha convertido en un grito de guerra común en la derecha, el senador Ted Cruz (republicano de Texas) criticó que "las grandes empresas tecnológicas pusieran su pulgar en la balanza y sesgaran el discurso político y público."

A finales de 2017, una industria que antes gozaba de una amplia confianza y popularidad entre los estadounidenses -la misma industria que Wyden había visto como "el pequeño" que necesitaba protección dos décadas antes- había pasado a ser conocida por la izquierda y la derecha por igual como " Big Tech ". El epíteto, un eco de las pasadas cruzadas contra las Grandes Empresas, los Grandes Bancos, las Grandes Tabacaleras y las Grandes Farmacéuticas, evocaba no sólo el poder sino la corrupción, una fuerza que debía ser frenada.

El primer golpe a la Sección 230 llegó en 2018, cuando el Congreso aprobó y Trump firmó un proyecto de ley bipartidista para luchar contra el tráfico sexual en línea, eliminando el escudo de responsabilidad para los sitios que lo facilitaban, a sabiendas o no. Los sitios que alojaban anuncios "personales" para adultos cerraron por completo en lugar de enfrentarse a demandas, un cambio que muchos trabajadores sexuales dijeron que los hizo menos seguros. Al no poder anunciarse ni seleccionar a sus clientes en línea, volvieron a la calle para hacer negocios.

Desde entonces, el Congreso ha luchado por encontrar un camino a seguir. En 2018, los republicanos celebraron audiencias para investigar la supuesta supresión por parte de Facebook de los influenciadores pro-Trump, Diamond y Silk, mientras que la izquierda criticó el papel de las redes sociales en el ascenso del teórico de la conspiración Alex Jones. Un mes después de que Facebook dijera que prohibir a Jones sería " contrario a los principios básicos de la libertad de expresión ", lo hizo, respondiendo a la creciente presión que también llevó a Apple, Spotify, YouTube y, finalmente, a Twitter a prohibirlo por sus falsas declaraciones de que el tiroteo en la escuela de Newtown, Connecticut, en 2012 fue un engaño.

En ese momento, nadie creía que las políticas de las empresas tecnológicas se aplicaran de forma coherente u objetiva. Así que Facebook ideó una solución novedosa: un panel de revisión semiindependiente y sin ánimo de lucro, llamado Consejo de Supervisión, formado por expertos en libertad de expresión y derechos humanos de todo el mundo.

En 2019, aliados de Trump como el senador Josh Hawley (republicano) pedían cambios en la sección 230 que exigieran a las plataformas ser políticamente neutrales para recibir protección legal. " Google y Facebook no deberían ser una ley en sí mismos ", dijo Hawley. "No deberían poder discriminar a los conservadores".

El brote de covid-19 en 2020 supuso nuevas pruebas para las plataformas. Grandes franjas de la derecha, incluido Trump, rechazaron la orientación científica sobre cómo detener la propagación.

De nuevo, las empresas consiguieron enfurecer tanto a la izquierda como a la derecha. Sus algoritmos recompensaron teorías conspirativas atractivas pero sin fundamento, como un vídeo viral titulado "Plandemic" que avanzaba una serie de afirmaciones conspirativas sobre los orígenes del virus, cómo se propaga y la seguridad de las máscaras y las vacunas. Al mismo tiempo, sus sistemas de moderación -ahora parcialmente automatizados, con moderadores humanos enviados a casa debido a las restricciones de covid- se apresuraron a eliminar tales contenidos en virtud de las nuevas políticas que prohíben la desinformación sobre el virus.

Mientras tanto, las plataformas se endurecían poco a poco con Trump, que empezó a predecir unas "elecciones amañadas" y a ridiculizar los votos por correo como "fraudulentos", sentando las bases para su intento de disputar los resultados de las próximas elecciones presidenciales. La reticencia de las empresas tecnológicas a penalizar a un presidente en funciones chocaba con sus políticas contra la desinformación electoral, una de las pocas y estrechas categorías de falsedades, junto con el covid-19 y la desinformación sobre vacunas, que habían prometido vigilar.

En mayo de 2020, Twitter ocultó por primera vez un tuit de Trump tras una etiqueta de verificación de hechos. La Casa Blanca tomó represalias con una orden ejecutiva que instaba a la Comisión Federal de Comunicaciones a reinterpretar la Sección 230 para debilitar o eliminar el escudo de responsabilidad de las plataformas tecnológicas. Siete meses más tarde, Trump amenazó con vetar un proyecto de ley bipartidista de gastos de defensa a menos que el Congreso derogara primero la Sección 230. (No lo hizo, y el Congreso se negó a aprobarla). (No lo hizo, y el Congreso anuló posteriormente su veto).

Un momento de galvanización para la derecha se produjo en octubre de 2020, pocas semanas antes de las elecciones en las que el demócrata Joe Biden desbancó a Trump.

El New York Post, un tabloide de tendencia derechista, publicó una historia sobre materiales ilícitos encontrados en un ordenador portátil que supuestamente había pertenecido al hijo de Biden, Hunter. Más tarde, Facebook y Twitter dijeron que habían sido advertidos días antes por las autoridades federales de que debían estar atentos a las operaciones de influencia extranjera relacionadas con las elecciones, incluyendo posibles maniobras de "hackeo y filtración". Ambas reaccionaron rápida y agresivamente, y Facebook utilizó sus algoritmos para limitar la difusión del artículo de The Post en su red. Twitter prohibió todos los enlaces al artículo y suspendió la cuenta de The Post.

Las medidas provocaron la indignación de la derecha, cuyos líderes consideraron que las empresas tecnológicas de Silicon Valley ejercían su poder para enterrar un informe periodístico de un importante periódico en lo que parecía un intento de ayudar al candidato demócrata en las próximas elecciones. Incluso algunos críticos de la izquierda se preguntaron si las plataformas se habían extralimitado al sustituir su juicio por el de una organización periodística establecida, si bien un tabloide con algunos errores infames en su historial.

Aunque siguen existiendo dudas sobre la historia del portátil, una investigación posterior de The Washington Post pareció validar al menos parte de la información del New York Post. El entonces director general de Twitter, Jack Dorsey, acabó disculpándose por lo que describió como un error honesto, mientras que Mark Zuckerberg, de Facebook, reconoció recientemente que su empresa también se equivocó.

La moderación de contenidos en el punto de mira

Las plataformas suspendieron finalmente a Trump tras el atentado del 6 de enero de 2021 en el Capitolio de EE.UU., con el argumento de que sus continuas publicaciones cuestionando las elecciones corrían el riesgo de incitar a más violencia. Twitter le prohibió permanentemente, y Facebook y YouTube emitieron suspensiones indefinidas.

Estas medidas, que se produjeron después de que Trump perdiera el control del poder, reforzaron la sensación entre los críticos de ambos bandos de que las empresas tecnológicas estaban inventando las reglas sobre la marcha, con un dedo puesto en los vientos políticos y un ojo en sus rivales, mientras cada una se esforzaba por no jugarse el cuello sola.

Entre la historia de Hunter Biden y la prohibición de Trump, algunos líderes conservadores habían visto suficiente. Estaban dispuestos a que el gobierno recuperara parte del poder que antes había confiado a las empresas de Internet.

En mayo de 2021, el gobernador de Florida, el republicano Ron DeSantis, firmó una ley estatal que prohibía a las grandes plataformas de redes sociales "censurar" las publicaciones de los funcionarios electos, los candidatos a cargos públicos o las principales organizaciones de noticias. Texas siguió con una ley que iba aún más lejos, impidiendo que las plataformas limitaran la expresión en línea de cualquier tejano -no solo de los políticos o de los medios de comunicación- en función de su punto de vista político. Ambas leyes también exigen que las plataformas en línea sean más transparentes en cuanto a sus normas y a la justificación de sus decisiones de moderación.

Numerosos estados han elaborado proyectos de ley similares, que podrían entrar en vigor si las leyes de Texas y Florida sobreviven a los desafíos legales en curso.

En una sentencia que dejó de lado décadas de precedentes, el Tribunal de Apelación del 5º Circuito de Estados Unidos confirmó en septiembre la ley de medios sociales de Texas, sentando las bases para que los tribunales reinterpreten la Primera Enmienda en la era digital.