El mundo científico está agitado después de las recomendaciones de dos de las revistas académicas más prestigiosas, The American Statistician and Nature, de que se retire el término “significación estadística”.

En su introducción al número especial de The American Statistician sobre el tema, los editores de la revista instan a “moverse a un mundo más allá de” p <0.05, el famoso umbral del 5 por ciento para determinar si el resultado de un estudio es estadísticamente significativo. Si un estudio pasa esta prueba, significa que la probabilidad de que un resultado se deba solo al azar es inferior al 5 por ciento. A menudo se ha entendido que esto significa que vale la pena prestar atención al estudio.

El mensaje básico de la revista, pero no necesariamente el consenso de los 43 artículos sobre este tema, uno de los cuales contribuí, fue que los científicos, ante todo, deberían “abarcar la incertidumbre” y “ser reflexivos, abiertos y modestos”.

Si bien estas son buenas cualidades, creo que los científicos no deben dejar que se deje de lado la precisión y el rigor que exige la ciencia. La incertidumbre es inherente a los datos. Si los científicos debilitan aún más el ya muy débil umbral de 0.05, eso haría inevitablemente que los hallazgos científicos sean más difíciles de interpretar y que sea menos probable que se confíe en ellos.

Acumulando dificultad sobre dificultad

En la práctica tradicional de la ciencia, un científico genera una hipótesis y diseña experimentos para recopilar datos en apoyo de hipótesis. Luego, él o ella recopila datos y realiza análisis estadísticos para determinar si los datos de hecho respaldan la hipótesis.

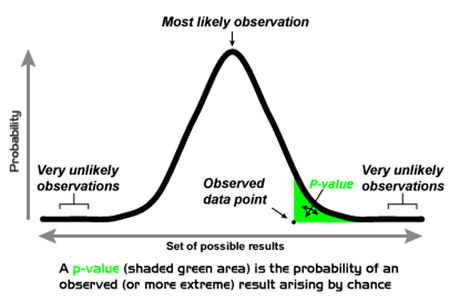

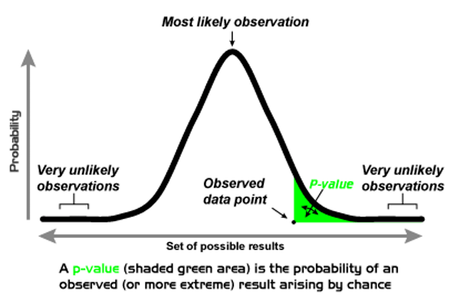

Un análisis estadístico estándar es el valor p. Esto genera un número entre 0 y 1 que indica un apoyo fuerte, marginal o débil de una hipótesis.

Pero me preocupa que el abandono de los estándares basados en la evidencia para estos juicios hará que sea aún más difícil diseñar experimentos, y mucho menos evaluar sus resultados. Por ejemplo, ¿cómo podría uno incluso determinar un tamaño de muestra adecuado sin un nivel de precisión específico? ¿Y cómo se interpretan los resultados de la investigación?

Me preocupa que el abandono de los estándares basados en la evidencia para estos juicios hará que sea aún más difícil diseñar experimentos

Estas son preguntas importantes, no solo para los investigadores de las agencias de financiamiento o reguladoras, sino para cualquier persona cuya vida diaria esté influenciada por juicios estadísticos. Eso incluye a cualquier persona que tome medicamentos, se someta a cirugía, maneje o monte en vehículos, invierta en el mercado de valores, tenga seguro de vida o dependa de pronósticos meteorológicos precisos … y la lista continúa. Del mismo modo, muchas agencias reguladoras se basan en estadísticas para tomar decisiones todos los días.

Los científicos deben tener el lenguaje para indicar que un estudio, o grupo de estudios, proporcionó evidencia significativa a favor de una relación o un efecto. La significación estadística es el término que sirve a este propósito.

Los grupos detrás de este movimiento

La hostilidad al término “significación estadística” surge de dos grupos.

El primero está compuesto en gran parte por científicos decepcionados cuando sus estudios producen p = 0.06. En otras palabras, aquellos cuyos estudios simplemente no hacen el corte. En gran parte, son científicos que consideran que el estándar 0.05 es un obstáculo demasiado alto para publicarse en las revistas académicas que son una fuente importante de conocimiento académico, así como también de tenencia y promoción.

El segundo grupo está preocupado por la falla en replicar los estudios científicos, y culpan a las pruebas de significación en parte por este fracaso.

Por ejemplo, un grupo de científicos repitió recientemente 100 experimentos de psicología publicados. Noventa y siete de los 100 estudios originales informaron un hallazgo estadísticamente significativo (p <0,05), pero solo 36 de los experimentos repetidos también lograron un resultado significativo.

El fracaso de tantos estudios en replicarse puede atribuirse parcialmente al sesgo de publicación, que se produce cuando solo se publican hallazgos significativos. El sesgo de publicación hace que los científicos sobreestimen la magnitud de un efecto, como la relación entre dos variables, lo que hace menos probable la replicación.

Para complicar aún más la situación es el hecho de que investigaciones recientes muestran que el corte del valor p no proporciona mucha evidencia de que se haya encontrado una relación real. De hecho, en estudios de replicación en ciencias sociales, ahora parece que los valores de p cercanos al umbral estándar de 0.05 probablemente signifiquen que una afirmación científica es incorrecta. Es solo cuando el valor de p es mucho más pequeño, tal vez menos de 0.005, que las afirmaciones científicas probablemente muestren una relación real.

La confusión que lleva a este movimiento

Muchos no estadísticos confunden el valor de p con la probabilidad de que no se haya hecho ningún descubrimiento.

Veamos un ejemplo del artículo de Nature. Dos estudios examinaron el aumento del riesgo de enfermedad después de tomar un medicamento. Ambos estudios estimaron que los pacientes tenían un riesgo 20 por ciento mayor de contraer la enfermedad si tomaban el medicamento que si no lo hicieran. En otras palabras, ambos estudios estimaron que el riesgo relativo era de 1.20.

Sin embargo, el riesgo relativo estimado de un estudio fue más preciso que el otro, porque su estimación se basó en los resultados de muchos más pacientes. Por lo tanto, la estimación de un estudio fue estadísticamente significativa, y la estimación del otro estudio no lo fue.

Los autores citan esta inconsistencia, que un estudio obtuvo un resultado significativo y el otro no, como evidencia de que la significación estadística lleva a una mala interpretación de los resultados científicos.

Los estándares de evidencia deben aumentarse al requerir valores p más pequeños

A pesar de ello, creo que un resumen razonable es simplemente que un estudio recopiló pruebas estadísticamente significativas y otro no, pero las estimaciones de ambos estudios sugirieron que el riesgo relativo estaba cerca de 1.2.

A dónde ir desde aquí

Estoy de acuerdo con el artículo de Nature y The American Statistician en que los datos recopilados de todos los estudios científicos bien diseñados deberían estar disponibles al público, con resúmenes completos de los análisis estadísticos. Junto con los valores p de cada estudio, es importante publicar estimaciones de los tamaños del efecto e intervalos de confianza para estas estimaciones, así como descripciones completas de todos los análisis de datos y su procesamiento.

Por otro lado, solo los estudios que proporcionan pruebas sólidas a favor de asociaciones importantes o nuevos efectos deben publicarse en las principales revistas. Para estas revistas, los estándares de evidencia deben aumentarse al requerir valores p más pequeños para el informe inicial de relaciones y nuevos descubrimientos. En otras palabras, hacer que los científicos publiquen resultados de los que estén aún más seguros.

La conclusión es que el desmantelamiento de los estándares aceptados de evidencia estadística disminuirá la incertidumbre que los científicos tienen al publicar sus propias investigaciones. Pero también aumentará la incertidumbre del público al aceptar los hallazgos que publican, y eso puede ser problemático.

Autor: Valen E. Johnson, Profesor Universitario Distinguido y Director del Departamento de Estadística en la Universidad de Texas A&M

Artículo publicado en The Conversation y cedido para su reubicación en Psyciencia.

Artículos recomendados:

La revisión por pares tiene algunos problemas, pero la comunidad científica está trabajando en ello

Las revistas científicas de psicología no estarían muy interesadas en publicar los estudios de replicación

De 100 estudios de psicología, sólo 39 resultados fueron reproducibles, ¿qué significa esto?

La práctica basada en la evidencia en psicología: una conversación con Scott Lilienfeld