Durante los últimos meses he estado dedicando las entradas de los viernes a describir diferentes estrategias existentes para abordar los problemas tipo Bandido Multibrazo (Multi-Armed Bandit) e implementarlas en Python. Creando de este modo una colección de código que puede ser interesante para la realización de comparaciones entre algoritmos. Por eso, recientemente he publicado este código como paquete en la cuenta de GitHub de Analytics Lane. Un paquete al que he llamado . En esta entrada vamos a ver cómo se puede instalar y el uso básico de esta librería Python para resolver el Bandido Multibrazo.

Instalación de mablane

La liberia mablane se ha publicado en GitHub, por lo que es posible emplear pip para su instalación. Para ello solamente se tienen que escribir el siguiente comando en la terminal

pip install git+https://github.com/analyticslane/mablane.git

Lo que descargara el código y lo debería instalar como un paquete más de Python. A partir de este momento se puede usar el código del paquete normalmente en nuestro código de Python.

Utilización de librería Python para resolver el Bandido Multibrazo

Una vez instalada la librería se puede importar las clases para crear los diferentes bandidos, disponibles en mablane.bandits, y las clases para crear los diferentes agentes, disponibles en mablane.algortims. Por ejemplo, para comparar el rendimiento de Epsilon-Greedy, los algoritmos de seguimiento y UCB1 se puede usar un código como el siguiente.

import numpy as np import matplotlib.pyplot as plt from mablane.bandits import BinomialBandit from mablane.algortims import Epsilon, Pursuit, UCB1 # Fijación de la semilla np.random.seed(0) # Creación de los bandidos bandits = [BinomialBandit(0.02), BinomialBandit(0.06), BinomialBandit(0.10)] # Creación del agente pursuit = Pursuit(bandits) epsilon = Epsilon(bandits) ucb1 = UCB1(bandits) # Simulación pursuit.run(100000) epsilon.run(100000) ucb1.run(100000) pursuit.plot(True, label='Pursuit') epsilon.plot(True, label='Epsilon') ucb1.plot(True, True, label='UCB1') plt.legend()

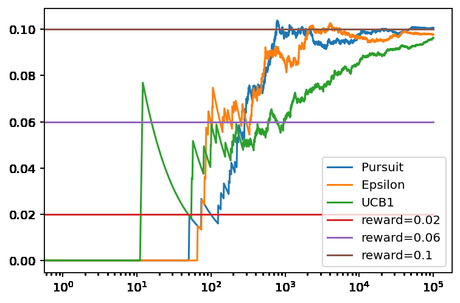

Obteniendo como resultado la siguiente figura.

En la que se puede ver que para este ejemplo el algoritmo que más rápidamente identifica el mejor bandido es el de seguimiento (pursuit), seguido de Epsilon-Greedy. Unos resultados similares a los que hemos visto a lo largo de estos últimos meses. Aunque ahora es más fácil realizar comparaciones ya que tememos todos los algoritmos en un único paquete.

Contenido de la librería

En estos momentos la librería contiene dos clases para la creación de bandidos:

Por otro lado, existen una clase para cada uno de los 16 algoritmos que se han visto durante estos últimos meses:

En el futuro posiblemente agregare nuevas clases con otras implementaciones de bandidos y agentes.

Conclusiones

La creación de una librería Python para resolver el Bandido Multibrazo con el código escrito durante los últimos hace que sea más fácil su utilización, además de facilitar la creación de comparaciones y benchmarks de cara a seleccionar el algoritmo más adecuado para cada ocasión.

Imagen de Jaesung An en Pixabay