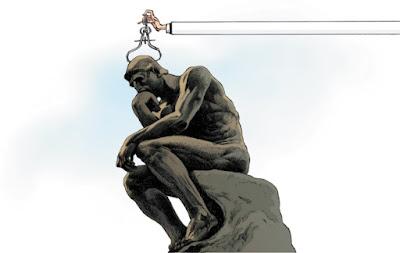

Os datos sobre as actividades científicas están a ser cada volta mais empregados para goberna-la ciencia. Avalaicions sobre investigación que foron no seu intre deseñadas individualmente para o seu contexto específico e realizadas por pares, son agora cotians i están baseadas en métricas1. O problema é que a avaliación pasou de estar baseada en valoracions de expertos a depender desas métricas. Os indicadores teñen proliferado: normalmente con boas intencions, non sempre ben informados, e decote mal aplicados. Cando organizacions sen coñecemento sobre as boas prácticas e a interpretación axeitada de indicadores levan a cabo as avaliacions, corremo-lo risco de dana-lo sistema científico cos mesmos instrumentos diseñados para melloralo.

Antes do ano 2000, os expertos empregaban o Science Citation Index do Institute for Scientific Information (ISI), na súa versión de CD-ROM para realiza-las analises especializadas. En 2002, Thomson Reuters lanzou unha plataforma web integrada que fixo accesible a un público amplo a base da datos Web of Science. Logo apareceron outros índices de citas que se erexiron en competencia de Web of Science: Scopus de Elevier (2004) e Google Academico (versión beta creada en 2004). Outros instrumentos baseados na web foron introducidos logo como InCites (que emprega Web of Science) e SciVal (que emprega Scopus) e tamén software para analizar perfis individuais de citas baseados en Google académico (Publish or Perish que aparecu en 2007).

No 2005, Jorge Hisch, físico da Universidade de California en San Diego, propuxo o índice-h, que fixo popular o reconto de citas de investigadores individuais. O interese no factor de impacto das revistas académicas medrou incesantemente dende 1995. Recentemente apareceron medidas de uso social e comentarios online: F1000Prime estableceuse en 2002, Mendeley en 2008 e Altmetric.com en 2011.

No tanto que os investigadores da cienciometría, cientístas sociais e xestores de investigacións, temos observado con crecente preocupación o emprego incorrecto xeneralizado dos indicadores na avaliación do desempeño científico. Os seguintes son alguns dos numerosísimos exemplor posilbes. En todo o mundo, as universidades se teñen obsesionado coa súa posición nos rankings globais (como o Ranking de Shanghai e a lista de Times Higher Education), cando estas listas están baseadas no que ó noso xuizo son datos inexactos e indicadores arbritrarios.

Algunhas organizacions lle piden o índice-h ós candidatos que se presentan a ofertas de emprego. Varias universidades basean a promoción interna nuns valores "umbral" do índice-h e no número de artigos en revistas de "alto impacto". Os CVs se teñen transformado en oportunidades de se gabar destas "puntuacions", en particular en biomediciña. Por todas partes, os organismos supervisores instan de xeito prematuro ós seus estudantes de doutorado que publiquenen revistas de ""alto impacto" e conquiran financiamento externo.

Nos paises escandinavos e China algunhas universidades distribuen fondos de investigación ou bonificacion sobre a base dun número: por exemplo, calculando puntuacions individuais de impacto para repartir "recusos de desempeño", ou dando ós investigadores unha prima por publicacions nunha revista con un factor de impacto superior a 152

Por estas razons presentase o Manifesto de Leiden, recibe o nome da conferencia na que cristalizou. Os seus dez principios non son ningunha novidade para os expertos en cientometría, mais ningún de nós sería quen de recitalos na súa totalidade pois ata ese intre non tiñan sido codificados. Recoñecidos cientometristas, como Eugene Garfield (fundador de ISI), enunciaran xa alguns destes principios,3 mais non son tidos en conta cando os avaliadores informan ós xestores das universidades que non son expertos na metodoloxía pertinente. Os cientístas que percuran literatura para disputar ou impugnar avaliacions só atopan as informacions precisas no que son, para eles, revistas opacas e difíciles de acceder.

A seguir unha síntese das bóas prácticas na avaliación baseada en indicadores métricos para que os investigadores poidan pedir contas ós avaliadors e para que os avaliadores podan pedir contas ós indicadores.

DEZ PRINCIPIOS

1. A Avaliación cuantitativa ten que apoiar á valoración cualitativa por expertos.

Os indicadores poden correxi-la tendencia a perspectivas sesgadas que se dan na revisión por pares e facilita-lo debate. Neste senso, os indicadores poden fortalecer a avaliación por pares pois tomar decisions sobre compañeiros é difícil sen varias fontes de información. Porén, os avaliadores non deben ceder á tentación de supeditar as decisions ós números. Os indicadores non podes substituir ós razoamentos informados. Os decisores teñen plena responsablidade nas súas avaliacions.

2. O desempeño se debe medir concordando coas misions de investigación da institución, grupo ou investigador.

Os obxetivos dun programa de investigación teñen que ser especificados ó inicio, os indicadores empregados para medi-lo desempeño teñen que estar claramente relacionados con eses obxetivos. A elección e usos dos indicadores ten que ter en conta os contextos socio-económicos e culturais. Os científicos teñen diversas misions de investigación. A investigación para avanza-las fronteiras do coñecemento académico é diferente da investigación focalizada en proporcionar solucions a problemas sociais. A avaliación pode estar baseada en méritos relevantes para a industria, o desenrolo de políticas ou para os cidadans en xeral, no canto de méritos baseados en nocions académicas de excelencia. Non hai un modelo de avaliación que se poda aplicar en tódolos contextos.

3. A excelencia en investigación de relevancia local debe ser protexida.

En moitas partes do mundo, excelencia en investigación asociase únicamente coas publicacions en inglés. A lei española, por exemplo, explicita o desexo e a conveniencia de que os académicos españois publiquen en revistas de alto impacto. O factor de impacto calcúlase para revistas indexadas por Web of Science, que é unha base de datos aloxada nos Estados Unidos e que contén unha gran maioría de revistas en inglés. Estes sesgos son especialmente problemátios en ciencias sociais e humanidades(*), áreas nas que a investigación está orientada a temas rexionais e nacionais. Moitos outros cientistas teñen unha dimensión nacional ou rexional --Por exemplo, epidemioloxía do VIH na África subshariana-.

Este pluralismo e a relevancia social van sendo suprimidos cando se crean artigos de interés para os guardians do alto impacto: As revistas en inglés. Os sociólogos españois mais citados en Web of Science teñen traballado en modelos abstractos ou estudiado datos dos Estados Unidos. Nese proceso pérdese a especificidade dos sociólogos con alto impacto nas revistas en castelán: temas como a lexislación laboral local, a atención sanitaria para ancians ou o emprego de inmigrantes4. Indicadores baseados na literatura de alta calidade non inglesa servirían para identifciar e recompensa-la excelencia en investigación localmente relevante.

4. Os procesos de recopilación e análise de datos deben ser abertos, transparentes e simples.

A construcción das bases de datos precisas para avaliar debe seguir procesos establecidos antes de que a investigación remate. Esta ten sido a práctica común entre os grupos académicos e comerciais que teñen desenvolvido metodoloxías de avaliación durante varias décadas. Estes grupos publicaron os protocolos de referencia na literatura revisada por pares. Esta transparencia permite o escrutinio e control dos métodos. Por exemplo, en 2010, un debate público sobre as propiedades técnicas dun importante indicador empregado por un dos nosos grupos (o Centro de Estudos de Ciencia e Tecnoloxía (CWTS) da universidade de leiden, nos paises baixos), se saldou cunha revisión no cálculo deste indicador5. As novas empresas comerciais no campo da investigación e publicación deben respostar ós mesmos estándares. Ninguén ten porqué aceptar avalaicions automáticas saídas de caixas negras ou procesos impenetrables. A simplicidade é unha virtude dun indicador que favorece á transparencia. Mais indicadores simplísticos poden distornsiona la avaliación (véxase principio 7). Os avaliadores deben facer un esforzo para atopar un equilibrio: Indicadores simples que respeten a complexidade dos procesos de investigación descritos.

5. Os datos e análises deben estar abertos á verificación polos avaliados

Co fin de asegura-la calidade dos datos, os investigadores incluídos en estudos bibliométricos teñen que poder comprobar que a súas contribucions teñen sido correctamente identificadas. Os responsables e xestores dos procesos de avaliación deben garanti-la exactitude dos datos empregados mediante métodos de autoverificación ou auditoría por terceiras partes. As universidades poderían implementar este principio nos seus sistemas de información. Este debería ser un principio reitor na selección de proveedores destes sistemas. A compilación e procesado de datos de alta calidade, precisos e rigurosos, leva tempo e custa cartos. Os responsables deben asignar presupostos á altura destas necesidades de calidade.

6. As diferenzas nas prácticas de publicación e citación entre campos científicos deben ser tidas en conta.

A mellor práctica na avaliación é propor unha batería de indicadores e deixar que os distintos campos científicos seleccionen os indicadores que mellor lles representan. Fai uns anos, un grupo de historiadores recibiu unha puntuación relativamente baixa nunha avaliación nacional por pares porque escribían libros no canto de artigos en revistas indexadas en Web of Sciencie. Estes historiadores tiveron a mala sorte de formar parte do departamento de psicoloxía. A avaliación de historiadores e cientistas sociais require a inclusión de libros e literatura en lingua local; a avaliación de investigadores en informática precisa considera-las contribucions a conferencias.

A frecuencia de citación varía segundo os campos: as revistas mais citadas en ránkings de matemáticas teñen un factor de impacto ó redor de 3; as revistas mais citadas en ránkigns de bioloxía celular teñen fatores de impacto sobre o 30.

Polo tanto, son precisos indicadores normalizados por campo, e o método mais robusto de normalización está baseado en percentiles: cada publicación é ponderada segundo o percentil ó que pertencie na distribución de citacions do seu campo (por exemplo, o percentil 1%, 10%, 20% mais alto). Unha única publiación altamente citada mellora un pouco a posición dunha universidade nun ránking baseado en percentiles, mais pode propusar á universidade dun lugar medio ás primeiras posicions nun ránking baseado en promedios das citas6

7. A avaliación individual de investigadores debe basearse na valoración cualitativa do seu portafolio de investigación.

O índice-h aumenta coa idade do investigador, malia que este xa non publique. O índice-h varía por campos: os cientistas en ciencias da vida poder chegar a 200; os físicos a 100 e os cientistas sociais a 20 ou 307. É un índice que depende da base de datos: hai informáticos que teñen un índice-h de 10 en Web of Sciencie, mais de 20 ou 30 en Google Scholar8. Ler e valora-lo traballo dun investigador é moito mais apropiado que confiar nun único número. Aínda cando se comparan un grande número de cientistas, é mellor adoptar un enfoque que considere información diversa sobre cada individuo, incluindo ós seus coñecementos, experiencia, actividades e influenza.

8. Debese evitar-la concreción improcedente e a falsa precisión.

Os indicadores de ciencia e tecnoloxía tenden á ambiguidade a á incertidume, fundamentanse en hipóteses que non están universalmente aceptadas. Por esta razón, as boas prácticas empregan múltiples indicadores co fin de construir un retrato robusto e plurarl. Na medida que sexa posible cuantifica-la a información sobre a incertidume e o erro debería acompañar ós valores dos indicadores publicados, por exemplo empregnado barras de erro. Se isto non fose posile, os productores de indicadores deberían cando menos evitar ofrecer un falso nivel de precisión. Por exemplo, o factor de impacto de revistas publicase con tres decimais para evitar empates. Nembargantes, dada a ambiguidade conceptual e a variabilidade aleatoria das citas, non ten senso distinguir entre revistas por pequenas diferenzas no factor de impacto. Debe evitarse a falsa precisión: só un decimal está xustificado.

9. Deben recoñecerse os efectos sistémicos da avaluación e os indicadores.

Os indicadores mudan o sistema científico polos incentivos que establecen. Estes efectos deberían anticiparse. Esto significa que sempre é preferible ter unha batería de indicadores pois un só indicador é susceptible de xerar comportamentos estratéxicos e a substitución dos obxectivos (convertindo a ferramenta de medida nunha finalidade en sí mesma). Por exemplo, nos anos 90, Australia financiou investigación en universidades consonte cunha fórmula baseada principalmente no número de publicacions dun instituto. As universidades podían calcular o "valor" dunha publicación nunha revista arbitrada ; no ano 2000, o valor estimouse en 800 dólares australianos destinados a recursos de investigación. Como era de agardar, o número de artigos publicados por autores australianos subiu, mais nas revistas menos citadas, o que suxire que a calidade dos artigos disminuiu9(a)

10. Os indicadores deben ser examinados e actualizados periódicamente.

As funcions da investigación e os obxectivos da avaliación mudan ou se desprazan, e o sistema de investigación co-evolue con eles. Medidas que foron útiles no seu día pasan a seren non axeitadas e aparecen novos indicadores. Polo tanto, os sistemas de indicadores teñen que ser revisados e cecais modificados. Ó decatarse dos efectos da súa fórmula simplista de avaliación, en 2010 Australia adoptou a iniciativa Excellence in Research for Australia, que é mais complexa e pon énfase na calidade.

Pasos segientes

Sendo fidel a estes dez principios, a avaliación da investigación pode xogar un papel importante no desenrolo da ciencia a a súas interaccions coa sociedade. Os indicadores de investigación poden proporcionar información crucial que sería difícil de xuntar ou entender a partires de experiencias individuais. Mais non se debe permitir que a información cuantitativa se convirta nun obxectivo por sí mesma. As mellores decisións adoptanse combinando estatísticas robustas sensibles ós obxectivos e a natureza da investigación avaliada. Tanto a evidencia cuantitativa como a cualitativa son precisas (cada unha ó seu xeito). As decisions sobor da ciencia teñen que ser tomadas en base a procesos de alta calidade informados por datos fiables.

Bibliografía orixinal:

↑ 1 Wouters, P. in Beyond Bibliometrics: Harnessing Multidimensional Indicators of Scholarly Impact (eds Cronin, B. & Sugimoto, C.) 47–66 (MIT Press, 2014).

↑ 2 Shao, J. & Shen, H. Learned Publishing 24, 95–97 (2011).

↑ 3 Seglen, P. O. Br. Med. J. 314, 498–502 (1997). Garfield, E. J. Am. Med. Assoc. 295, 90–93(2006).

↑ 4 López Piñeiro, C. & Hicks, D. Res. Eval. 24, 78–89 (2015).

↑ 5 van Raan, A. F. J., van Leeuwen, T. N., Visser, M. S., van Eck, N. J. & Waltman, L. J. Informetrics 4, 431–435 (2010).

↑ 6 Waltman, L. et al. J. Am. Soc. Inf. Sci. Technol. 63, 2419–2432 (2012).

↑ 7 Hirsch, J. E. Proc. Natl Acad. Sci. USA 102, 16569–16572 (2005).

↑ 8 Bar-Ilan, J. Scientometrics 74, 257–271 (2007).

↑ 9 Butler, L. Res. Policy 32, 143–155 (2003).

Notas persoais:

(*) Compre salientar que no campo dos coidados moitos estudos se fan con ferramentas cualitativas e se atopan con este problema. A barreira faise ainda maior si se trata de publicar ciencia en linguas minorizadas ainda que se trate de temas de gran relevancia local (como acontece cos estudos publicados en galego).

(a) Neste caso dase por válido un argumento que, en xeral, se da por falso; percibo certa incoherencia.