La optimización web SEO Técnico Avanzado consiste en el análisis de 11 puntos importantes y críticos para favorecer la valoración que Google hace de una página web. Nosotros no trabajamos con ningún tipo de técnica secreta, por lo que hemos decidido explicar y compartir en esta guía, punto por punto, en qué consiste optimizar una página web para Google desde un punto de vista técnico.

En Solutum ofrecemos una auditoría completa para asegurar que su página web estará técnicamente 100% optimizada para Google. Este servicio consiste en realizar un análisis profundo y detallado de todos los aspectos pertinentes a su página web profesional que realmente tienen un valor en el posicionamiento en buscadores. El fin es tanto optimizar la web resolviendo los errores que pueda tener como evitar que esos errores se deriven en penalizaciones por parte de los buscadores, sobre todo de Google.

A pesar del nivel de dificultad y los tecnicismos que esta materia requiere, hemos tratado de utilizar un lenguaje que pueda ser ampliamente entendido hasta por aquellos que no son “profesionales SEO”.

1. Análisis de redirecciones

Una redirección es, en pocas palabras, una herramienta que resuelve la necesidad de pasar el contenido que existe en una página a otra página. Esto ocurre cuando una web, ya sea en estructura o en contenido, queda obsoleta pero sigue relacionada a una URL que es la que los usuarios conocen y los buscadores tienen indexada.

1.1 ¿Por qué es bueno hacer una redirección?

1.1 ¿Por qué es bueno hacer una redirección?

Gracias a las redirecciones se puede mover toda una página o incluso un dominio de sitio de forma que cuando los usuarios lleguen a esa página no se encuentren con un error (el más conocido es el error 404) que les diga que la página a la que están accediendo ya no existe.

No se puede simplemente vaciar la página o borrar la dirección, y no sólo por el riesgo a bajar de categoría a causa de los errores, sino porque el valor de los enlaces de entrada que tuviera esta página se perdería.

1.2 ¿Qué tipo de redirección es la más favorable?

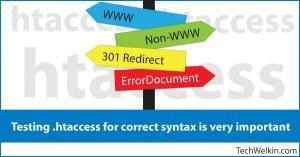

Existen diferentes tipos de redirecciones permanentes y temporales, aunque la más habitual y favorable de cara a los buscadores es la redirección 301, que es permanente. Gracias a esta redirección se pueden mantener los enlaces entrantes, lo cual implica que el ranking de esa página no decaerá para los buscadores. Además supone un cambio inmediato de una página a otra de forma que los usuarios ni siquiera se dan cuenta del cambio de dirección, ya que acceden igualmente al contenido que estaban buscando.

1.3 ¿Cómo proceder para hacer una redirección?

Una vez hecha la redirección, se debe avisar al buscador del cambio y debe plasmarse en el archivo .htaccess o el html. El soporte de Google ofrece más información.

Cuando las redirecciones están bien hechas, los buscadores las aceptan, pero es conveniente asegurarse de que la redirección es inmediata, ya que hay algunas que tardan varios segundos en completarse y en esos casos los buscadores no ven bien la pérdida de tiempo.

2. Configuración de robots.txt

Cuando se crea una página web es conveniente crear un archivo conocido como robots.txt en el cual se deben introducir las directrices para componer y estructurar la web siguiendo una sintaxis específica [que indique lo que se permite “Allow” y lo que no “Disallow”]. Su función es de gran importancia, pues el contenido de este archivo es leído por el buscador para juzgar si lo que hay dentro debe o no excluirse de los resultados de búsqueda.

2.1 ¿Por qué son útiles los robots.txt?

Muy sencillo. Poniendo como ejemplo el proceso de creación de una web cualquiera, existen siempre páginas en construcción hasta el momento en que la página es lanzada al público y se empieza a permitir el acceso a sus secciones. El archivo robots.txt permite incluir dentro las URL de las páginas específicas que aún no se deberían abrir al público porque aún no están listas.

Cuando los buscadores llegan a la web y leen el archivo robots.txt, juzgan el contenido de esos enlaces y deciden si respetarlos dejándolos fuera de la indexación. Básicamente, este archivo serviría para avisar a un buscador de que existen páginas que no quieres mostrar (por el momento) y por ello no deberían aparecer en las búsquedas que realizan los usuarios.

2.2 ¿Es importante tener un archivo robots.txt?

Es aconsejable tener siempre un archivo robots.txt al lanzar una página web. No siempre una página web tiene un robots.txt, de modo que el primer paso que hay que dar es buscarlo y en caso de que falte, crear uno y empezar a introducir los enlaces excluidos. Si por el contrario ya existiera uno, habría que comprobar si su estructura es correcta y si los enlaces incluidos son válidos. Crearlo es bastante sencillo.

2.3 Grados de accesibilidad para la web

Se pueden especificar la páginas que serán accesibles desde los buscadores. Estos son:

2.3.1 Permitir acceso completo

Si se quiere que Google o cualquier buscador indexe la página completa, hay que especificar los siguientes términos.

-

User-agent: *

-

Disallow:

2.3.2 Excluir acceso completo

Si por el contrario se quiere que Google o cualquier otro buscador no indexe todavía la web completa, deben especificarse los siguientes términos:

-

User-agent: *

-

Disallow: /

2.3.3 Excluir acceso a carpetas concretas

Si la web contiene unas carpetas o archivos completos que no conviene tener indexados (aún), deben especificarse los siguientes términos:

-

User-agent: *

-

Disallow: /temp/

-

Disallow: /develop/

3. Configuración sitemap.xml

En una web normalmente no todas las páginas que la componen son igual de importantes como para que aparezcan indistintamente en los resultados de búsquedas. El sitemap.xml o mapa del sitio es un archivo en el que se especifican algunas de las URL’s que componen la web principal y las ordena jerárquicamente.

3.1 ¿Cómo se crea un sitemap.xml?

Crear un sitemap.xml es increíblemente fácil. Hoy día existen numerosas herramientas o plugins en plataformas como WordPress que te ayudan a componer tu propio mapa si tu página no cuenta con uno, aunque en la mayoría de los casos éstos se generan automáticamente.

3.2 ¿Por qué es necesario controlar el Sitemap.XML?

La principal función del sitemap.xml es informar a Google de qué páginas y enlaces contiene tu página web, es decir, cuál es el contenido total de la web.

No implica que haya que incluir todos y cada uno de los enlaces que componen una web, sino aquellos que tengan relevancia para quien la controla. Las páginas que no tienen importancia de poder ser encontradas en buscadores no deberían estar incluidas, incluso deberían ser excluidas a través del archivo robots.txt. Este documento es un elemento más a tener en cuenta en la optimización de las páginas web de cara a los buscadores.

Optimizar un sitemap.xml consiste básicamente en asegurarse de que los enlaces importantes están incluidos, que están correctamente escritos y actualizados.

3.3 Tener más de un sitemap-xml

Se puede tener más de un sitemap.xml si una página web tiene diferentes versiones para distintos idiomas. De esta forma habría que generar una copia de cada mapa por cada idioma con sus enlaces concretos.

Así mismo, se puede generar un sitemap distinto si se quiere tener un blog o una página dentro de la propia web que se considere lo bastante importante para que los buscadores la indexen por separado.

Más información acerca de este tema: http://www.solutum.com/blog/seo-internacional-geo-targeting-para-google/

4. Contenido duplicado

El contenido duplicado es un aspecto bastante penalizado por los buscadores y también es uno de los problemas más comunes de las páginas web que pueden ser considerados como una mala práctica de la web en concreta, aunque la mayoría de las veces no se hace de forma malintencionada.

El contenido duplicado sucede cuando dos URL’s que son diferentes conduce a la misma página, o lo que es lo mismo, muestran el mismo contenido. A pesar de que se llame contenido duplicado, no se limita a dos copias. Es más, cuanto mayor es el porcentaje de contenido duplicado en un web, mayor es la probabilidad de que Google acabe sancionándola.

4.1 ¿Cuándo se considera duplicado un contenido?

El contenido duplicado consiste básicamente a que una web contiene bloques de contenido de una extensión considerable y que son o bien igual o bien muy parecidos. Cuando más del 80% del texto escrito en esos bloques aparece repetido dos o más veces en dos o más páginas dentro de un mismo dominio, ese contenido pasa inmediatamente a tacharse de duplicado y es por tanto objetivo de los buscadores, cuya misión es evitar que esto ocurra.

No sólo se considera contenido duplicado si ocurre dentro de un mismo dominio, si no también si entre diferentes dominios el contenido coincide en gran medida.

4.2 ¿Por qué ocurre el contenido duplicado?

La gran mayoría de las veces el contenido duplicado ocurre porque la web genera enlaces con argumentos que no son detectados por Google como un enlace más de la web principal, sino como una copia de la misma. Un argumento es lo que va escrito en una dirección web detrás de un símbolo de interrogación [?] y que normalmente responde a parámetros de navegación introducidos con intención de realizar búsquedas específicas.

Se generan, por ejemplo, cuando se ofrecen cuestionarios para elegir las características de los productos o cuando se realizan búsquedas sobre palabras concretas dentro de una web. La búsqueda muestra un enlace con los resultados de los parámetros introducidos y este enlace es “leído” por Google sólo hasta el signo [?], por lo que a pesar de ser direcciones diferentes, se identifica el contenido de ambas como el mismo.

Y no es la única razón de la creación de contenido duplicado. También puede suceder que un título o una descripción estándar se haya copiado en muchas páginas de un dominio, o porque los buscadores comprueben que se puede ingresar a la web a través de diferentes formas de escribir una dirección como por ejemplo:

-

dirección.com

-

dirección.com/index

-

www.dirección.com/index

4.3 ¿Qué solución tiene el contenido duplicado?

Lo principal es evitar que Google indexe todas las páginas que tienen un contenido duplicado para que no jueguen en contra de su página web. Es importante en estos casos localizarlas en el mapa de la web, configurar los parámetros URL y excluir aquellos que sean perjudiciales para que los buscadores no los tengan en cuenta.

5. Errores de rastreo

Se conocen como errores de rastreo aquellas páginas enlazadas a la web que por algún motivo se encuentran vacías pero aún pueden ser localizadas por los buscadores.

5.1 ¿Por qué ocurren los errores de rastreo?

Las razones por las que una página da un error de rastreo son varias, aunque la mayoría de las veces suele ser un problema que responde a dos situaciones. La primera es que la página ha dejado de estar operativa debido a un error en la estructura interna (por ejemplo, si uno o varios caracteres de no se corresponden con la URL real y no es reconocida como tal). Entonces se dice que el enlace a la URL está roto. Otro motivo es que la página haya sido eliminada porque ya no era necesaria o había quedado obsoleta pero la URL ha seguido activa, de modo que la página simplemente está vacía.

5.2 ¿Qué consecuencias tienen los errores de rastreo?

El resultado es que, cuando los clientes llegan a estas URLs, se encuentran con pantallas que les informan de un error en la página (el más habitual es el ERROR 404). Muchas veces las propias webs no son conscientes de que tienen este tipo de problemas en sus páginas web ya que aparecen cuando se intenta acceder desde el exterior.

No sólo pueden dar una mala imagen de la web y provocar la pérdida de un visitante que, por frustración o desinterés, abandone la búsqueda, sino que los buscadores ven mal que una web o dominio tenga enlaces rotos y pueden incluso penalizar a las páginas si tienen muchos. El problema es que los buscadores no avisan de todos estos errores. Sólo informan de que han localizado una pequeña selección de enlaces rotos en una web, y lo hacen a través de la herramienta Google Webmaster Tools.

5.3 ¿Qué solución se le puede dar a los errores de rastreo?

Lo principal es realizar un rastreo del árbol estructural de la web para localizar cualquier enlace roto y a partir de ahí decidir si se quiere arreglar el enlace o eliminar la página enlazada.

Nota: Durante una auditoría SEO Avanzado, Solutum realiza un rastreo a fondo del árbol estructural de la web del cliente y localiza cualquier un error de rastreo que surja. Después propone soluciones en el presupuesto dependiendo de si el enlace está roto o si la página ha sido eliminada.

6. Longitud de los títulos y descripciones

Toda web tiene secciones, apartados, páginas con contenido escrito en los que los títulos y las descripciones son elementos fundamentales siempre presentes. Muchos de esos títulos y descripciones aparecen después repetidos en los resultados de búsquedas de los buscadores y la mayor parte de las veces su longitud no se ajusta a las medidas de la página.

6.1 ¿Por qué es un problema la longitud de los títulos y descripciones?

A menos que se especifique concretamente al estructurar la página o al publicar los contenidos, el título que aparecerá en un resultado de búsqueda se corresponderá con el título dado al contenido del mismo. En cuanto a las descripciones, los buscadores con Google a la cabeza, pueden utilizar tanto la descripción corta que se le haya querido dar al contenido o directamente mostrarán frases del mismo contenido que puedan ser claves y se correspondan con las palabras clave que los usuarios están buscando.

La longitud de estos textos debe seguir unos parámetros establecidos por los buscadores, ya que si superan el número de caracteres no se ajustarán al espacio dado y aparecerán cortados, con lo que la información realmente queda sesgada o desaparece en muchos casos.

6.2 ¿Cómo optimizar los títulos y descripciones?

Cada buscador ha establecido un número de caracteres determinado según la estructura de su página de resultados de búsqueda. Lo correcto sería hacer un recorrido por la web y localizar cuáles son los contenidos que realmente no tienen un título y una descripción ajustada a los buscadores para que los usuarios los encuentren útiles y concisos, con la información necesaria que están buscando y que les hará entrar en la web a leer.

Volviendo a Google, que es el buscador más grande en España, el número de caracteres que ha especificado para sus resultados de búsqueda es de 55 caracteres para los títulos y 155 caracteres para las descripciones.

7. Optimización de las imágenes

Mucha gente desconoce la importancia de optimizar cada uno de los elementos que forman la web. Las imágenes son el recurso visual más importante de una web, pues son el apoyo e ilustración del contenido y por ello deben estar optimizadas para que los usuarios tengan claro cuál es su función en la web. A pesar de que los buscadores aún no son capaces de leer imágenes e identificarlas, lo que sí pueden hacer es analizar toda la información que las rodea.

Hay varios aspectos a tener en cuenta para llevar a cabo la optimización de las imágenes:

7.2 Reducir el peso de las imágenes

Si las imágenes de una web pesan muchos megas, la página se ralentizará, por lo que es conveniente bajar el tamaño de las imágenes. Para ello hay varias opciones como:

-

Reducir las dimensiones: ajustar las imágenes a las dimensiones exactamente necesarias ahorrará mucho peso.

-

Guardar las imágenes en Photoshop con un formato especial para páginas web.

-

Convertir las imágenes en formato “lossy” a través de páginas cómo Tiny PNG, eesto reducirá el peso de las imágenes considerablemente.

7.3 Usar un título adecuado

No sólo es bueno titular las imágenes en la web, si no que es conveniente darles a las imágenes guardadas en el ordenador un título adecuado, separando las palabras con barras o guiones. Una imagen con un título genérico como pueden ser 123.jpg o foto43.jpg no da ninguna pista al buscador para ubicarla, pero un título más detallado como jersey-de-punto-negro-blanco-frente.jpg puede ayudar a identificar la imagen. Debemos tener en cuenta que esto también sirve para favorecer que las imágenes aparezcan en los resultados de imágenes de Google si un usuario busca una palabra clave contenida en el título.

7.4 Optimizar el texto que rodea a la imagen

Es de gran ayuda para el buscador relacionar una imagen con el texto al que está adherida, si lleva pie de foto o una descripción, o se hace alguna referencia a la misma (con palabras claves que coincidan con el título).

7.5 Guardar las fotos

Aunque no lo parezca, forma parte de la optimización de las fotos e imágenes que son subidas a las webs el lugar en el que están guardadas. Así, tener una carpeta optimizada con un nombre característico y colocada en un lugar destacado del servidor en el que se encuentra la web ayudará enormemente a su optimización.

7.6 ¿Cómo se debe proceder?

Es conveniente realizar un barrido de la página web completa para identificar todas y cada una de las imágenes que se localicen en la web y que no estén convenientemente optimizadas de cara a los buscadores.

8. Problemas Prefix / Postfix

Los problemas prefix y postfix están relacionados con las URL’s de un sitio web.

8.1 ¿Qué puede suponer un problema prefix o postfix?

Decimos que suponen un problema por una sencilla razón. Supongamos que para entrar en una página en internet podemos hacerlo escribiendo en la caja de búsquedas distintas versiones de la misma URL:

-

www.ejemplo.com

-

www.ejemplo.com/ES

-

www.ejemplo.com/index

-

ejemplo.com

-

ejemplo.com/ES

-

ejemplo.com/index

Si al introducir cada variable en la caja de búsquedas el resultado le lleva a la misma página entonces hay un problema de programación por resolver. Y es que volvemos al tema del contenido duplicado que se traduce en que si a través de diferentes direcciones accedemos a la misma web, los buscadores darán por sentado que lo que ocurre es que esta misma web está duplicada en contenido y forma y la penalizará por ello.

8.2 ¿Por qué se genera un problema prefix o postfix?

Son muchos los factores que pueden generar un problema prefix o postfix, como el tipo de sistema en el que está montado la web, si es WordPress, Magento u otro, si se trata de una web online o no, etc. Suelen aparecer cuando se está trabajando sobre páginas cuyos sistemas están automatizados hasta cierto punto para hacer más fácil la labor de los programadores. Debido a esto, si por ejemplo estamos trabajando sobre una página web y escribiéndola desde cero lo más seguro es que no nos encontremos con este tipo de problemas.

8.3 ¿Cómo podemos resolver los problemas prefix y postfix?

Si, como hemos dicho, la página web funciona mediante un sistema automatizado, es posible que haya creado por defecto una réplica de la URL de la web y que eso esté generando de cara a los buscadores la apariencia de duplicación de contenido.

Cuando un problema como este aparece, las soluciones que se pueden aplicar son diversas y son numerosos los factores a tener en cuenta. La forma más sencilla es localizar aquellas direcciones que no se correspondan con la principal y redirigirlas a ella. Esta herramienta es de gran ayuda para encontrar páginas duplicadas.

Otra opción es mediante la creación de un documento .htaccess y escribir una serie de instrucciones para que los buscadores las lean y sepan que si encuentran páginas iguales cuyas URLs sean distintas, que en realidad no se trata de contenidos duplicados, sino de la propia web con un error de programación por solucionar.

8.4 ¿Cómo crear un archivo .htaccess?

El proceso para la creación de un archivo .htaccess (que significa acceso de Hiper-Texto) no es demasiado complicado. Se puede seguir una serie de pasos:

-

Lo primero es abrir un editor de texto como puede ser el SimpleText en los ordenadores Mac o Bloc de Notas en Windows y guardar el archivo con el nombre .htaccess (no olvidar el punto al comienzo) en la carpeta en la que quieras que el archivo tenga efecto, una carpeta relevante.

-

En caso de que el archivo se haya guardado automáticamente con el sufijo .txt habrá que borrarlo y renombrarlo. No vale únicamente borrando del nombre el sufijo. Habrá que mirar dentro de las propiedades del archivo.

-

A continuación, habrá que asegurarse de que el Ajuste de Línea del documento estará desactivado. Para ello, en el Bloc de Notas de Windows por ejemplo, hay que clicar en la barra de herramientas en Formato y ver si el Ajuste de Línea está marcado. Esto es necesario porque con el Ajuste de Línea activado, una frase que se escriba en el documento se ajustará al tamaño del archivo abierto. Esto no es conveniente dado que la mayoría de los comandos que se van a escribir en el .htaccess son muy largos y deberán ir en una sola línea recta.

-

Ahora el fichero está listo para ser escrito con los comandos que necesite la web. Hay que tener en cuenta que lo que se escriba en ese archivo afectará, no sólo a la propia carpeta en la que está guardado, sino a todas las carpetas que estén en su interior.

Una vez finalizado, hay que cargar el archivo .htaccess en la página web en modo ASCII.

9. Responsiveness: Diseño Web Adaptable – Responsive

La característica responsiveness de una web consiste en su adaptabilidad adecuada al cambio entre dispositivos. Por decirlo de otra forma, cuando una web ha sido creada básicamente para un visionado online en una pantalla de ordenador, su estructura y las dimensiones de sus elementos están determinados de una forma de acuerdo a unas medidas. La adaptabilidad a otros dispositivos quiere decir que cuando la web es abierta desde un teléfono móvil o una tablet, por ejemplo, tiene capacidad de responder al nuevo tamaño de la pantalla modificándose pero sin deformar la estructura de la página ni su contenido.

9.1 ¿Es un problema no tener una web adaptada?

Sí. Cuando un usuario trata de acceder a una web que no está adaptada desde un dispositivo que no es un ordenador pueden ocurrir dos hechos perjudiciales. El primero es que el tiempo de carga de la web puede ser muy largo y acabar provocando incluso un error que impida finalmente visualizar la página.

El segundo es que la estructura de la página se modificaría de forma que se deformasen los contenidos impidiendo su lectura y visualización. Esto puede frustrar al usuario y que se decida a abandonar la página, sobre todo si quiere interactuar con la web como comprar algo o comentar. Además, si ya la página de por sí tenía algún error que la hacía ralentizarse, eso sumado a la falta de responsiveness puede generar un tiempo de carga aún mayor.

9.2 ¿Qué es necesario para que una web sea responsive?

Existen hoy en día varias plataformas como Magento o WordPress en las que la opción responsive está (en la mayoría de los casos) implícita al diseñar y crear una web, de modo que al lanzarla inmediatamente se puede abrir desde cualquier dispositivo. No obstante, puede darse que algunas webs más antiguas o que hayan sido creadas en otro tipo de plataformas no estén preparadas técnicamente para adaptarse a los diferentes tipo de pantalla. En este caso se podría modificar la estructura interna de la web para que cumpliera con las dimensiones de cada tipo de dispositivo o valorar si quizás es más viable económicamente y en cuestión de tiempo trasladar toda la web a una nueva versión en una plataforma responsive.

10. Tiempo de carga

El tiempo de carga es el tiempo que habitualmente tarda una página web en abrirse tras haberla introducido en el buscador o haber pinchado en su enlace. Tiene una influencia muy negativa para los buscadores que una web tarde más de lo habitualmente recomendado en abrirse y comenzar a ser funcional.

10.1 ¿Por qué tarda una página en cargar?

Es muy importante tener este aspecto controlado, pues pueden ser muchos los motivos que hagan a una web ser demasiado lenta a la hora de cargarse. La principal razón de este problema es que la web tenga en su estructura elementos que pesen mucho para el servidor y por eso su tiempo de reacción es mucho más lento. Concretamente puede deberse a que la página contiene demasiadas imágenes o muy pesadas, mucho texto, sliders que ralentizan el funcionamiento normal, material audiovisual pesado, etc.

10.2 ¿Qué solución se puede aplicar al tiempo de carga elevado?

Debe realizarse un barrido completo de la web para localizar aquellos elementos conflictivos que estén generando problemas. Para agilizar el proceso de carga simplemente habría que bajar la calidad o el formato de las imágenes y vídeos, reducir la cantidad de texto, suprimir el uso de sliders o sustituirlos por elementos menos conflictivos, etc. Todo depende realmente de cuál sea el origen del problema.

10.3 Herramientas para averiguar el tiempo de carga (todas gratis)

11. Uso de microformatos

Los microformatos son etiquetas, también conocidas como entidades, que deben integrarse en el lenguaje HTML de una web para categorizar el contenido de forma que los buscadores sepan exactamente a qué está haciendo referencia esa información.

11.1 ¿Son necesarios los microformatos?

Realmente no es imprescindible introducir los microformatos, sin embargo, los buscadores valoran muy positivamente que las webs los introduzcan en su lenguaje porque eso les permite calificar por sí mismos la relevancia que tendrá el contenido para los usuarios.

Existen etiquetas específicas para los microformatos. Por ejemplo, para categorizar un evento se añadiría junto con la información en el lenguaje HTML el microformato “hcalendar”, o para identificar productos que después aparecerán en los resultados de búsqueda el microformato “itemscope”, etc.

Los microformatos pueden además incluir informaciones específicas sobre el contenido al que hacen referencia llamadas propiedades. Por ejemplo, las propiedades de un producto serían el precio, el color, el material, etc. Así, cuando el usuario realizar una búsqueda sobre el producto y una palabra clave como el precio aparecerá perfectamente marcado ya en los resultados de búsqueda.

11.2 ¿Cómo introducir microformatos?

La introducción de los microformatos no es sencilla. De hecho se trata de una técnica bastante avanzada y compleja para la que se necesita conocer mínimamente el lenguaje de programación. La mejor opción es que sea un programador el que los implemente.

Para más información sobre los microformatos se pueden consultar las webs Schema y Microformats.

NOTA: La auditoría SEO Técnico Avanzado está siempre incluida en nuestros paquetes SEO. Sin embargo también se puede contratar como servicio. Aqui puede solicitar un presupuesto.

Fuentes imágenes:

- http://301redirects.net/301-redirect-directions.jpg

- http://www.techwyse.com/blog/wp-content/uploads/2010/04/robots-txt1.gif

- http://villageswebdesigns.com/wp-content/uploads/2015/01/Google-XML-Sitemaps-Generator-for-Wordpress.png

- http://www.dirigodev.com/content/uploaded/blogfeaturedimages/Increasing-Googlebot-Crawl-Budget-Part-4-Crawl-Errors.jpg

- http://seoexpertdanny.com/wp-content/uploads/2014/05/GooglePanda.png

http://techwelkin.com/wp-content/uploads/2013/11/htaccess-tester-check-online.jpg

- http://rack.0.mshcdn.com/media/ZgkyMDEyLzEyLzE5LzYzL21hc2hhYmxlcmVzLmpwZwpwCXRodW1iCTk1MHg1MzQjCmUJanBn/297e3a40/91c/mashable-responsive-design.jpg

- http://www.skipser.com/i/2/images/a1/Google-Page-Speed-Service.jpg